Aqui no WPBeginner, orientamos milhões de usuários sobre como otimizar seus sites para pesquisa e aumentar o tráfego orgânico. Descobrimos que um aspecto do SEO que os iniciantes geralmente ignoram é o arquivo robots.txt, que ajuda os mecanismos de pesquisa a descobrir, rastrear e indexar seu site.

Esse arquivo de texto simples funciona como um conjunto de instruções, orientando os bots dos mecanismos de pesquisa sobre quais partes do seu site devem ser acessadas e quais devem ser deixadas de lado.

Ao otimizar seu arquivo robots.txt, você pode garantir que os mecanismos de pesquisa se concentrem no rastreamento e na indexação do conteúdo mais importante, evitando que eles desperdicem recursos em áreas menos importantes do seu site.

Este artigo mostrará algumas dicas sobre como criar um arquivo robots.txt perfeitamente otimizado para seu site WordPress, maximizando seu potencial de SEO.

O que é um arquivo Robots.txt?

O Robots.txt é um arquivo de texto que os proprietários de sites podem criar para informar aos bots dos mecanismos de pesquisa como rastrear e indexar as páginas de seus sites.

Normalmente, ele é armazenado no diretório raiz (também conhecido como pasta principal) de seu site. O formato básico de um arquivo robots.txt é o seguinte:

1 2 3 4 5 6 7 | User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap] |

Você pode ter várias linhas de instruções para permitir ou não URLs específicos e adicionar vários sitemaps. Se você não proibir um URL, os bots dos mecanismos de busca presumirão que têm permissão para rastreá-lo.

Veja a seguir um exemplo de arquivo robots.txt:

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml |

No exemplo do robots.txt acima, permitimos que os mecanismos de pesquisa rastreiem e indexem arquivos na pasta de uploads do WordPress.

Depois disso, não permitimos que os bots de busca rastreassem e indexassem plug-ins e pastas de administração do WordPress.

Por fim, fornecemos o URL do nosso sitemap XML.

Você precisa de um arquivo Robots.txt para seu site WordPress?

Se você não tiver um arquivo robots.txt, os mecanismos de pesquisa ainda rastrearão e indexarão seu site. No entanto, você não poderá informar a eles quais páginas ou pastas não devem ser rastreadas.

Isso não terá muito impacto quando você começar um blog pela primeira vez e não tiver muito conteúdo.

No entanto, à medida que seu site crescer e você adicionar mais conteúdo, provavelmente desejará ter um controle melhor sobre como o site é rastreado e indexado.

Aqui está o motivo.

Os bots de busca têm uma cota de rastreamento para cada site.

Isso significa que eles rastreiam um determinado número de páginas durante uma sessão de rastreamento. Se eles esgotarem o orçamento de rastreamento antes de terminar de rastrear todas as páginas do seu site, eles voltarão e retomarão o rastreamento na próxima sessão.

Isso pode reduzir a taxa de indexação de seu site.

Você pode corrigir isso impedindo que os bots de busca tentem rastrear páginas desnecessárias, como as páginas de administração do WordPress, os arquivos de plug-in e a pasta de temas.

Ao não permitir páginas desnecessárias, você economiza sua cota de rastreamento. Isso ajuda os mecanismos de pesquisa a rastrear ainda mais páginas em seu site e a indexá-las o mais rápido possível.

Outro bom motivo para usar um arquivo robots.txt é quando você deseja impedir que os mecanismos de pesquisa indexem um post ou uma página do seu site.

Essa não é a maneira mais segura de ocultar o conteúdo do público em geral, mas o ajudará a impedir que o conteúdo apareça nos resultados de pesquisa.

Qual é a aparência de um arquivo Robots.txt ideal?

Muitos blogs populares usam um arquivo robots.txt muito simples. Seu conteúdo pode variar de acordo com as necessidades do site específico:

1 2 3 4 5 | User-agent: *Disallow:Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

Esse arquivo robots.txt permite que todos os robôs indexem todo o conteúdo e fornece a eles um link para os sitemaps XML do site.

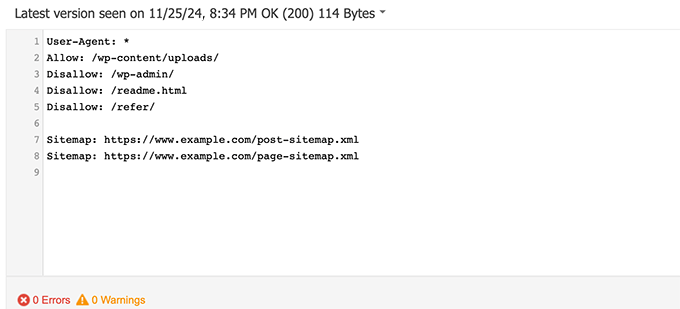

Para sites WordPress, recomendamos as seguintes regras no arquivo robots.txt:

1 2 3 4 5 6 7 8 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

Isso diz aos bots de busca para indexar todas as imagens e arquivos do WordPress. Isso impede que os bots de busca indexem a área de administração do WordPress, o arquivo leia-me e os links de afiliados camuflados.

Ao adicionar sitemaps ao arquivo robots.txt, você facilita a localização de todas as páginas do seu site pelos bots do Google.

Agora que você já sabe como é um arquivo robots.txt ideal, vamos dar uma olhada em como criar um arquivo robots.txt no WordPress.

Como criar um arquivo Robots.txt no WordPress

Há duas maneiras de criar um arquivo robots.txt no WordPress. Você pode escolher o método que funciona melhor para você.

Método 1: Edição do arquivo Robots.txt usando o All in One SEO

OAll in One SEO, também conhecido como AIOSEO, é o melhor plugin de SEO para WordPress do mercado, usado por mais de 3 milhões de sites. É fácil de usar e vem com um gerador de arquivos robots.txt.

Para saber mais, consulte nossa análise detalhada do AIOSEO.

Se você ainda não tiver o plug-in AIOSEO instalado, consulte nosso guia passo a passo sobre como instalar um plug-in do WordPress.

Observação: uma versão gratuita do AIOSEO também está disponível e tem esse recurso.

Depois que o plug-in estiver instalado e ativado, você poderá usá-lo para criar e editar o arquivo robots.txt diretamente da área de administração do WordPress.

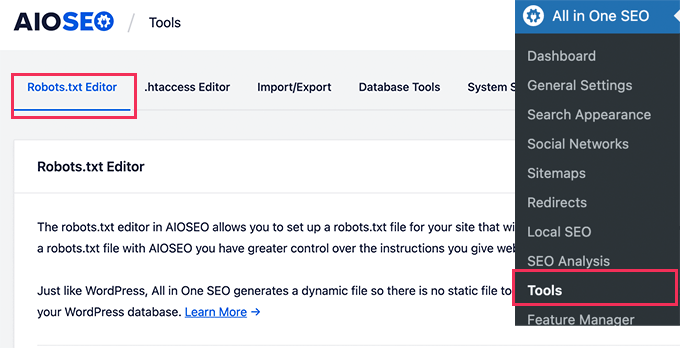

Basta acessar All in One SEO ” Ferramentas para editar seu arquivo robots.txt.

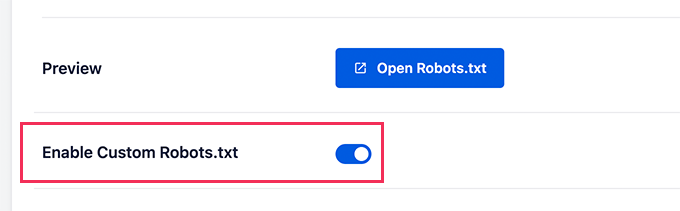

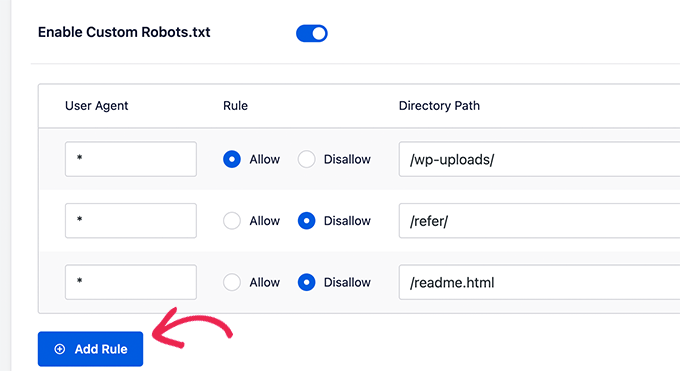

Primeiro, você precisará ativar a opção de edição clicando na opção “Enable Custom Robots.txt” (Ativar Robots.txt personalizado) na cor azul.

Com essa opção ativada, você pode criar um arquivo robots.txt personalizado no WordPress.

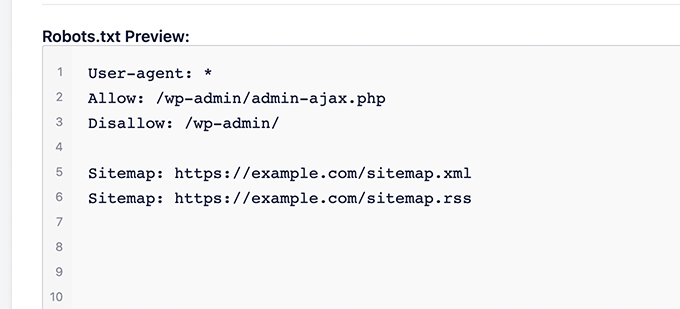

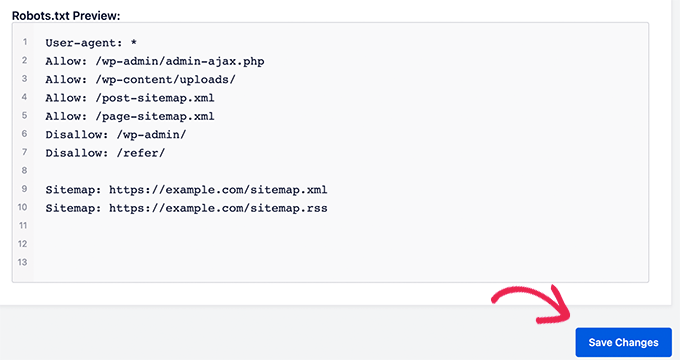

O All in One SEO mostrará o arquivo robots.txt existente na seção “Robots.txt Preview” (Visualização do arquivo robots.txt) na parte inferior da tela.

Essa versão mostrará as regras padrão que foram adicionadas pelo WordPress.

Essas regras padrão informam aos mecanismos de pesquisa que não devem rastrear seus arquivos principais do WordPress, permitem que os bots indexem todo o conteúdo e fornecem a eles um link para os sitemaps XML do seu site.

Agora, você pode adicionar suas próprias regras personalizadas para aprimorar o robots.txt para SEO.

Para adicionar uma regra, insira um agente de usuário no campo “User Agent”. O uso de um * aplicará a regra a todos os agentes de usuário.

Em seguida, selecione se deseja “Permitir” ou “Não permitir” o rastreamento dos mecanismos de pesquisa.

Em seguida, digite o nome do arquivo ou o caminho do diretório no campo “Directory Path” (Caminho do diretório).

A regra será aplicada automaticamente ao seu robots.txt. Para adicionar outra regra, basta clicar no botão “Add Rule”.

Recomendamos adicionar regras até que você crie o formato ideal de robots.txt que compartilhamos acima.

Suas regras personalizadas terão a seguinte aparência.

Quando terminar, não se esqueça de clicar no botão “Save Changes” (Salvar alterações) para armazenar suas alterações.

Método 2: Edição do arquivo Robots.txt usando o WPCode

O WPCode é um poderoso plug-in de snippets de código que permite adicionar códigos personalizados ao seu site de forma fácil e segura.

Ele também inclui um recurso útil que permite que você edite rapidamente o arquivo robots.txt.

Observação: Há também um plug-in gratuito do WPCode, mas ele não inclui o recurso de editor de arquivos.

A primeira coisa que você precisa fazer é instalar o plug-in WPCode. Para obter instruções passo a passo, consulte nosso guia para iniciantes sobre como instalar um plug-in do WordPress.

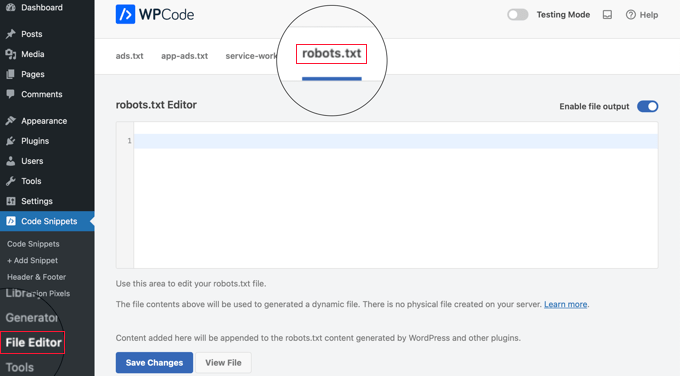

Na ativação, você precisa navegar até a página WPCode ” File Editor. Uma vez lá, basta clicar na guia “robots.txt” para editar o arquivo.

Agora, você pode colar ou digitar o conteúdo do arquivo robots.txt.

Quando terminar, certifique-se de clicar no botão “Save Changes” (Salvar alterações) na parte inferior da página para armazenar as configurações.

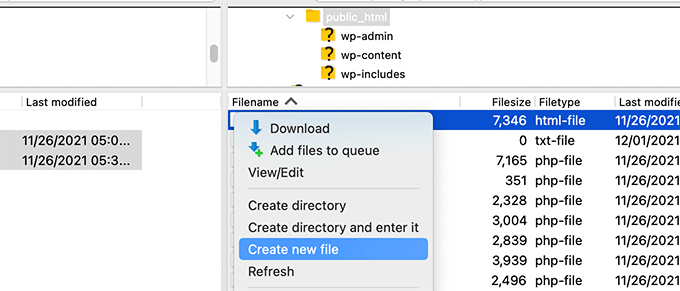

Método 3: Edição manual do arquivo Robots.txt usando FTP

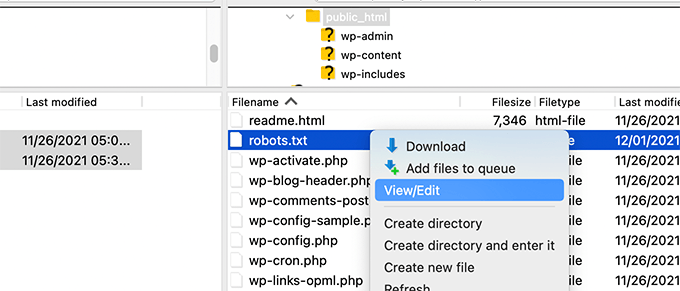

Para esse método, você precisará usar um cliente FTP para editar o arquivo robots.txt. Como alternativa, você pode usar o gerenciador de arquivos fornecido pela sua hospedagem do WordPress.

Basta conectar-se aos arquivos do seu site WordPress usando um cliente FTP.

Uma vez lá dentro, você poderá ver o arquivo robots.txt na pasta raiz do seu site.

Se você não encontrar um, provavelmente não tem um arquivo robots.txt.

Nesse caso, você pode ir em frente e criar um.

O Robots.txt é um arquivo de texto simples, o que significa que você pode baixá-lo para o seu computador e editá-lo usando qualquer editor de texto simples, como o Notepad ou o TextEdit.

Depois de salvar as alterações, você pode fazer upload do arquivo robots.txt de volta para a pasta raiz do seu site.

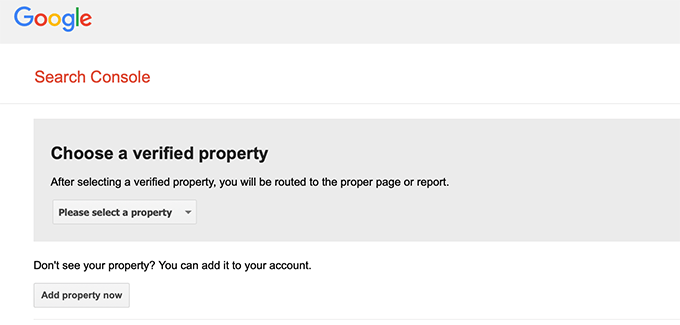

Como testar seu arquivo Robots.txt

Depois de criar o arquivo robots.txt, é sempre uma boa ideia testá-lo usando uma ferramenta de teste de robots.txt.

Há muitas ferramentas de teste de robots.txt no mercado, mas recomendamos usar a que está no Google Search Console.

Primeiro, você precisará ter seu website vinculado ao Google Search Console. Se ainda não tiver feito isso, consulte nosso guia sobre como adicionar seu site WordPress ao Google Search Console.

Em seguida, você pode usar a ferramenta de teste de robôs do Google Search Console.

Basta selecionar sua propriedade na lista suspensa.

A ferramenta buscará automaticamente o arquivo robots.txt do seu site e destacará os erros e avisos, caso encontre algum.

Considerações finais

O objetivo de otimizar seu arquivo robots.txt é impedir que os mecanismos de pesquisa rastreiem páginas que não estejam disponíveis publicamente. Por exemplo, páginas em sua pasta wp-plugins ou páginas em sua pasta de administração do WordPress.

Um mito comum entre os especialistas em SEO é que o bloqueio de categorias, tags e páginas de arquivo do WordPress melhorará a taxa de rastreamento e resultará em indexação mais rápida e classificações mais altas.

Isso não é verdade. Isso também é contra as diretrizes para webmasters do Google.

Recomendamos que você siga o formato robots.txt acima para criar um arquivo robots.txt para o seu site.

Guias especializados sobre o uso do Robots.txt no WordPress

Agora que você sabe como otimizar seu arquivo robots.txt, talvez queira ver outros artigos relacionados ao uso do robots.txt no WordPress.

- Glossário: Robots.txt

- Como ocultar uma página do WordPress do Google

- Como impedir que os mecanismos de pesquisa rastreiem um site WordPress

- Como excluir permanentemente um site WordPress da Internet

- Como ocultar facilmente (Noindex) arquivos PDF no WordPress

- Como corrigir o erro “O Googlebot não pode acessar arquivos CSS e JS” no WordPress

- Como configurar corretamente o All in One SEO para WordPress (guia definitivo)

Esperamos que este artigo tenha ajudado você a aprender como otimizar seu arquivo robots.txt do WordPress para SEO. Talvez você também queira ver nosso guia definitivo de SEO para WordPress e nossas escolhas de especialistas para as melhores ferramentas de SEO para WordPress para aumentar seu site.

Se você gostou deste artigo, inscreva-se em nosso canal do YouTube para receber tutoriais em vídeo sobre o WordPress. Você também pode nos encontrar no Twitter e no Facebook.

Moinuddin Waheed

Thanks for this informative post about robots.txt file.

I didn’t know that websites should maintain this file in order to have a control over Google bots that how should they crawl over our pages and posts.

for beginner websites just starting out, is there a need to have robots.txt file or is there a way like plugin which can a make a robots.txt file for our website?

WPBeginner Support

Most SEO plugins help with setting up the robots.txt for a new site to prevent bots from scrolling sections they shouuldn’t.

Admin

Jiří Vaněk

Thanks to this article, I checked the robots.txt file and added URL addresses with sitemaps. At the same time, I had other problematic lines there, which were revealed by the validator. I wasn’t familiar with sitemaps in robots.txt until now. Thanks.

WPBeginner Support

You’re welcome, glad our guide could help!

Admin

Stéphane

Hi,

Thanks for that post, it becomes clearer how to use the robots.txt file. On most websites that you find while looking for some advice regarding the robots.txt file, you can see that the following folders are explicitly excluded from crawling (for WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

I don’t really understand the reasons to exclude those folders (is there one actually?). What would be your take regarding that matter?

WPBeginner Support

It is mainly to prevent anything in those folders from showing as a result when a user searches for your site. As that is not your content it is not something most people would want to appear for the site’s results.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC show the coverage error for “Disallow: /wp-admin/” Is this wrong?

WPBeginner Support

For most sites, you do not want anything from your wp-admin to appear as a search result so it is fine and expected to receive the coverage area when you deny Google the ability to scan your wp-admin.

Admin

Hansini

I am creating my robots.txt manually as you instructed for my WordPress site.

I have one doubt. when I write User-Agent: * won’t it allow another spamming robot to access my site?

Should I write User-Agent: * or User-Agent: Googlebot.?

WPBeginner Support

The User-Agent line is setting the rules that all robots should follow on your site, if you specify a specific bot on that line it would be setting rules for that specific bot and none of the others.

Admin

Nishant

What should we write to make google index my post?

WPBeginner Support

For having your site listed, you would want to take a look at our article below:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

should we also disallow /wp-content/themes/ ?

It is appearing in the search result when I run the command site:abcdef.com in google search

WPBeginner Support

You would not want to worry about blocking your themes folder and as you write SEO-friendly content you should no longer see the themes as a search result.

Admin

Salem

HI, What’s means ” Disallow: /readme.html & Disallow: /refer/ ” ?

WPBeginner Support

That means you’re telling search engines to not look at any referral links or the readme.html file.

Admin

sean

Hi, what are the pros and cons of blocking wp-content/uploads

Thank you

WPBeginner Support

If you block your uploads folder then search engines would not normally crawl your uploaded content like images.

Admin

Piyush

thanks for solve my problem

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Sir i m very confused about robot.txt many time i submitted site map in blogger but the after 3,4 days coming the same issue what is the exactly robot.txt.. & how submit that please guide me

WPBeginner Support

It would depend on your specific issue, you may want to take a look at our page below:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

If I no index a url or page using robots.txt file, does google shows any error in search console?

WPBeginner Support

No, Google will not list the page but if the page is listed it will not show an error.

Admin

Bharat

Hi

I have a question

i receive google search console coverage issue warning for blocked by robots.txt

/wp-admin/widgets.php

My question is, can i allow for wp-admin/widgets.php to robots.txt and this is safe?

WPBeginner Support

IF you wanted to you can but that is not a file that Google needs to crawl.

Admin

Anthony

Hi there, I’m wondering if you should allow: /wp-admin/admin-ajax.php?

WPBeginner Support

Normally, yes you should.

Admin

Jaira

May I know why you should allow /wp-admin/admin-ajax.php?

WPBeginner Support

It is used by different themes and plugins to appear correctly for search engines.

Amila

Hello! I really like this article and as I’m a beginner with all this crawling stuff I would like to ask something in this regard. Recently, Google has crawled and indexed one of my websites on a really terrible way, showing the pages in search results which are deleted from the website. The website didn’t have discouraged search engine from indexing in the settings of WordPress at the beginning, but it did later after Google showed even 3 more pages in the search results (those pages also doesn’t exist) and I really don’t understand how it could happen with “discourage search engine from indexing” option on. So, can the Yoast method be helpful and make a solution for my website to Google index my website on the appropriate way this time? Thanks in advance!

WPBeginner Support

The Yoast plugin should be able to assist in ensuring the pages you have are indexed properly, there is a chance before you discouraged search engines from crawling your site your page was cached.

Admin

Amila

Well yes and from all pages, it cached the once who doesn’t exist anymore. Anyway, as the current page is on “discourage” setting on, is it better to keep it like that for now or to uncheck the box and leave the Google to crawl and index it again with Yoast help? Thanks! With your articles, everything became easier!

WPBeginner Support

You would want to have Google recrawl your site once it is set up how you want.

Pradhuman Kumar

Hi I loved the article, very precise and perfect.

Just a small suggestion kindly update the image ROBOTS.txt tester, as Google Console is changed and it would be awesome if you add the link to check the robots.txt from Google.

WPBeginner Support

Thank you for the feedback, we’ll be sure to look into updating the article as soon as we are able.

Admin

Kamaljeet Singh

My blog’s robots.txt file was:

User-Agent: *

crawl-delay: 10

After reading this post, I have changed it into your recommended robots.txt file. Is that okay that I removed crawl-delay

WPBeginner Support

It should be fine, crawl-delay tells search engines to slow down how quickly to crawl your site.

Admin

reena

Very nicely described about robot.text, i am very happy

u r very good writer

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

What is Disallow: /refer/ page ? I get a 404, is this a hidden wp file?

Editorial Staff

We use /refer/ to redirect to various affiliate links on our website. We don’t want those to be indexed since they’re just redirects and not actual content.

Admin

Sagar Arakh

Thank you for sharing. This was really helpful for me to understand robots.txt

I have updated my robots.txt to the ideal one you suggested. i will wait for the results now

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Very helpful article. Thank you very much.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Thanks for share this useful information about us.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

thanks for update information for me. Your article was good for Robot txt. file. It gave me a piece of new information. thanks and keep me updating with new ideas.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Thanks , I added robots.txt in WordPress .Very good article

WPBeginner Support

Thank you, glad our article was helpful

Admin