Robots.txt é um arquivo de texto que permite a um site fornecer instruções para bots de rastreamento da web.

Ele informa aos mecanismos de busca como o Google quais partes do seu site eles podem e não podem acessar ao indexar seu site.

Isso torna o robots.txt uma ferramenta poderosa para SEO e também pode ser usado para garantir que certas páginas não apareçam nos resultados de pesquisa do Google.

Como Funciona o Robots.txt?

Robots.txt é um arquivo de texto que você pode criar para dizer aos bots dos mecanismos de busca quais páginas rastrear e indexar em seu site. Ele normalmente é armazenado no diretório raiz do seu site.

Mecanismos de busca como o Google usam rastreadores da web, às vezes chamados de robôs da web, para arquivar e categorizar sites. A maioria dos bots é configurada para procurar um arquivo robots.txt no servidor antes de ler qualquer outro arquivo do site. Um bot faz isso para ver se o proprietário do site tem instruções especiais sobre como rastrear e indexar seu site.

O arquivo robots.txt contém um conjunto de instruções que solicitam ao bot que ignore arquivos ou diretórios específicos. Isso pode ser por privacidade ou porque o proprietário do site acredita que o conteúdo desses arquivos e diretórios é irrelevante para a categorização do site nos mecanismos de busca.

Aqui está um exemplo de um arquivo robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Neste exemplo, o asterisco '*' após 'User-Agent' especifica que as instruções são para todos os mecanismos de busca.

Em seguida, permitimos que os mecanismos de busca rastreiem e indexem arquivos em nossa pasta de uploads do WordPress. Em seguida, proibimos que eles rastreiem e indexem pastas de plugins e do administrador do WordPress.

Observe que, se você não proibir uma URL, os bots dos mecanismos de busca assumirão que podem indexá-la.

Finalmente, fornecemos o URL do nosso sitemap XML.

Como Criar um Arquivo Robots.txt no WordPress

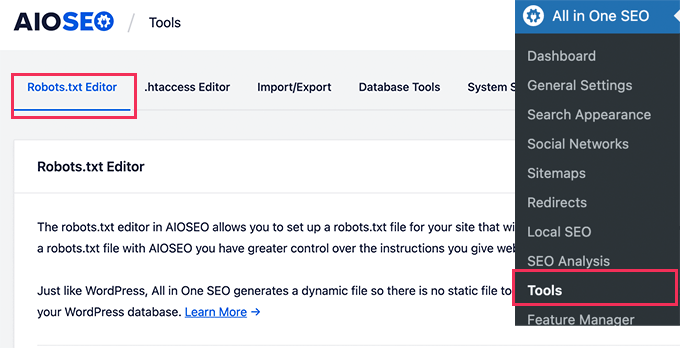

A maneira mais fácil de criar um arquivo robots.txt é usando o All in One SEO. É o melhor plugin de SEO para WordPress do mercado e vem com um gerador de arquivos robots.txt fácil de usar.

Outra ferramenta que você pode usar é o WPCode, um poderoso plugin de snippets de código que permite adicionar código personalizado ao seu site de forma fácil e segura. A versão Pro inclui um recurso útil que permite editar rapidamente o arquivo robots.txt.

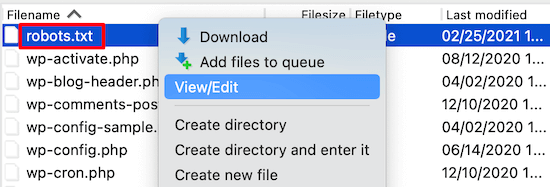

No entanto, se você tem familiaridade com código, pode criar o arquivo robots.txt manualmente. Você precisará usar um cliente FTP para editar o arquivo robots.txt. Alternativamente, você pode usar o gerenciador de arquivos fornecido pela sua hospedagem WordPress.

Para mais detalhes sobre como criar um arquivo robots.txt, consulte nosso guia sobre como otimizar seu robots.txt do WordPress para SEO.

Como Usar Robots.txt para Impedir que Mecanismos de Busca Rastrem um Site

Os motores de busca são a maior fonte de tráfego para a maioria dos sites. No entanto, existem algumas razões pelas quais você pode querer desencorajar os motores de busca de indexar seu site.

Por exemplo, se você ainda está construindo seu site, não vai querer que ele apareça nos resultados de busca. O mesmo vale para blogs privados e intranets empresariais.

Você pode usar regras de desautorização no seu arquivo robots.txt para pedir aos motores de busca que não indexem todo o seu site ou apenas certas páginas. Você encontrará instruções detalhadas em nosso guia sobre como impedir que os motores de busca rastreiem um site WordPress.

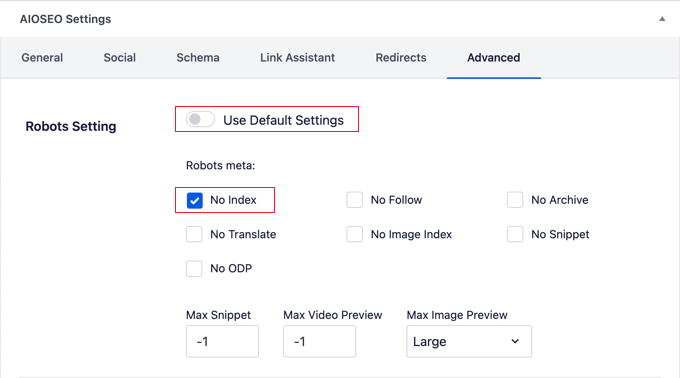

Você pode usar ferramentas como All in One SEO para adicionar automaticamente essas regras ao seu arquivo robots.txt.

É importante notar que nem todos os bots respeitarão um arquivo robots.txt. Alguns bots maliciosos até lerão o arquivo robots.txt para descobrir quais arquivos e diretórios eles devem priorizar.

Além disso, mesmo que um arquivo robots.txt instrua os bots a ignorar páginas específicas do site, essas páginas ainda podem aparecer nos resultados de pesquisa se estiverem vinculadas a outras páginas rastreadas.

Esperamos que este artigo tenha ajudado você a aprender mais sobre robots.txt no WordPress. Você também pode consultar nossa lista de Leitura Adicional abaixo para artigos relacionados sobre dicas, truques e ideias úteis do WordPress.

Se você gostou deste artigo, por favor, inscreva-se em nosso Canal do YouTube para tutoriais em vídeo do WordPress. Você também pode nos encontrar no Twitter e no Facebook.