W WPBeginner doradziliśmy milionom użytkowników, jak zoptymalizować ich witryny pod kątem wyszukiwania i zwiększyć ruch organiczny. Odkryliśmy, że jednym z aspektów SEO, który początkujący często pomijają, jest plik robots.txt, który pomaga wyszukiwarkom wykrywać, indeksować i indeksować Twoją witrynę.

Ten prosty plik tekstowy działa jak zestaw instrukcji, przewodnik dla botów wyszukiwarek, do których części witryny mają uzyskać dostęp, a które pozostawić w spokoju.

Optymalizując plik robots.txt, można upewnić się, że wyszukiwarki skupiają się na indeksowaniu najważniejszych treści, jednocześnie uniemożliwiając im marnowanie zasobów na mniej ważne obszary witryny.

W tym artykule przedstawimy kilka wskazówek, jak utworzyć doskonale zoptymalizowany plik robots.txt dla witryny WordPress, maksymalizując potencjał SEO.

Co to jest plik robots.txt?

Robots.txt to plik tekstowy, który właściciele witryn internetowych mogą utworzyć, aby poinformować boty wyszukiwarek, jak indeksować strony w ich witrynach.

Zazwyczaj jest on przechowywany w katalogu głównym (znanym również jako katalog główny) twojej witryny internetowej. Podstawowy format pliku robots.txt wygląda następująco:

1 2 3 4 5 6 7 | User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap] |

Możesz mieć wiele wierszy instrukcji, aby zezwolić lub nie zezwolić na określone adresy URL i dodać wiele map witryn. Jeśli adres URL nie zostanie zablokowany, boty wyszukiwarek przyjmą, że mogą go indeksować.

Oto jak może wyglądać przykładowy plik robots.txt:

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml |

W powyższym przykładzie robots.txt zezwoliliśmy wyszukiwarkom na indeksowanie plików w katalogu uploads naszego WordPressa.

Następnie uniemożliwiliśmy robotom wyszukiwarek indeksowanie wtyczek i katalogów administracyjnych WordPress.

Na koniec podaliśmy adres URL naszej mapy witryny XML.

Czy potrzebujesz pliku robots.txt dla twojej witryny WordPress?

Jeśli nie masz pliku robots.txt, wyszukiwarki nadal będą indeksować twoją witrynę internetową. Nie będziesz jednak w stanie wskazać im stron lub katalogów, których nie powinny indeksować.

Nie będzie to miało większego wpływu, gdy po raz pierwszy uruchamiasz bloga i nie masz dużo treści.

Jednak w miarę rozwoju twojej witryny internetowej i dodawania większej ilości treści, prawdopodobnie będziesz chciał mieć lepszą kontrolę nad tym, jak twoja witryna jest indeksowana i indeksowana.

Oto dlaczego.

Boty wyszukiwarek mają limit indeksowania dla każdej witryny internetowej.

Oznacza to, że indeksują określoną liczbę stron podczas sesji indeksowania. Jeśli wykorzystają swój budżet indeksowania przed zakończeniem indeksowania wszystkich stron w twojej witrynie, wrócą i wznowią indeksowanie w następnej sesji.

Może to spowolnić szybkość indeksowania twojej witryny internetowej.

Możesz to poprawić, uniemożliwiając robotom wyszukiwarek próbę indeksowania niepotrzebnych stron, takich jak strony administracyjne WordPress, pliki wtyczek i katalog motywów.

Wyłączając niepotrzebne strony, oszczędzasz swój limit indeksowania. Pomaga to wyszukiwarkom indeksować jeszcze więcej stron w twojej witrynie i indeksować je tak szybko, jak to możliwe.

Innym dobrym powodem do korzystania z pliku robots.txt jest chęć uniemożliwienia wyszukiwarkom indeksowania wpisu lub strony w twojej witrynie internetowej.

Nie jest to najbezpieczniejszy sposób na ukrycie treści przed opinią publiczną, ale pomoże zapobiec pojawianiu się treści w wynikach wyszukiwania.

Jak wygląda idealny plik robots.txt?

Wiele popularnych blogów korzysta z bardzo prostego pliku robots.txt. Ich treść może się różnić w zależności od potrzeb konkretnej witryny:

1 2 3 4 5 | User-agent: *Disallow:Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

Ten plik robots.txt umożliwia wszystkim robotom indeksowanie całej treści i zapewnia im odnośnik do map witryn XML.

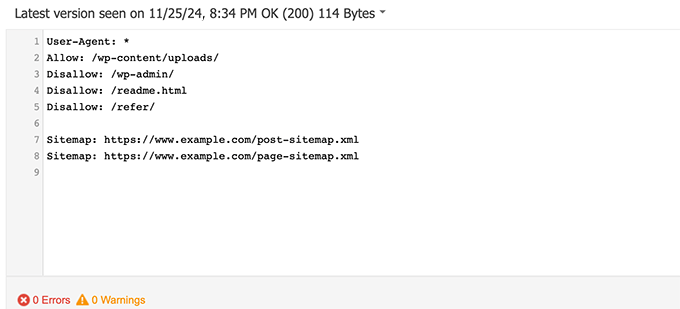

W przypadku witryn WordPress zalecamy następujące reguły w pliku robots.txt:

1 2 3 4 5 6 7 8 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

Powoduje to, że boty wyszukiwarek indeksują wszystkie obrazki i pliki WordPress. Uniemożliwia robotom wyszukiwarek indeksowanie obszaru administracyjnego WordPress, pliku readme i ukrytych odnośników partnerskich.

Dodając mapy witryn do pliku robots.txt, ułatwiasz robotom Google znalezienie wszystkich stron w twojej witrynie.

Teraz, gdy już wiesz, jak wygląda idealny plik robots.txt, przyjrzyjmy się, jak możesz utworzyć plik robots.txt w WordPress.

Jak utworzyć plik robots.txt w WordPress?

Istnieją dwa sposoby utworzenia pliku robots.txt w WordPress. Możesz wybrać metodę, która najbardziej Ci odpowiada.

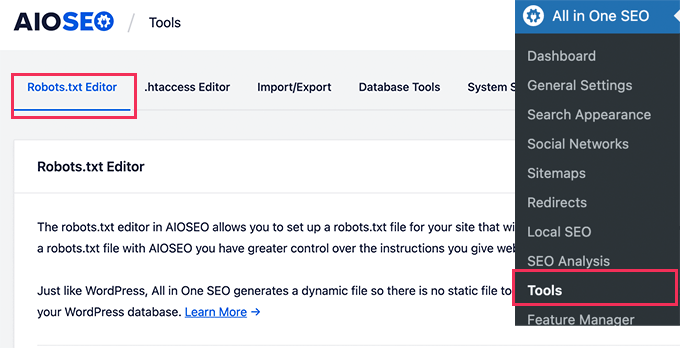

Metoda 1: Edycja pliku robots.txt przy użyciu All in One SEO

All in One SEO, znany również jako AIOSEO, to najlepsza wtyczka WordPress SEO na rynku, używana przez ponad 3 miliony witryn internetowych. Jest łatwa w użyciu i zawiera generator pliku robots.txt.

Aby dowiedzieć się więcej, zobacz naszą szczegółową recenzję AIOSEO.

Jeśli nie masz jeszcze zainstalowanej wtyczki AIOSEO, możesz zapoznać się z naszym przewodnikiem krok po kroku, jak zainstalować wtyczkę WordPress.

Uwaga: Dostępna jest również bezpłatna wersja AIOSEO, która posiada tę funkcję.

Po zainstalowaniu i włączaniu wtyczki można jej używać do tworzenia i edytowania pliku robots.txt bezpośrednio z obszaru administracyjnego WordPress.

Wystarczy przejść do All in One SEO ” Narzędzia, aby edytować twój plik robots.txt.

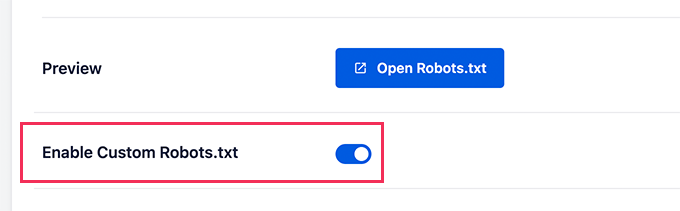

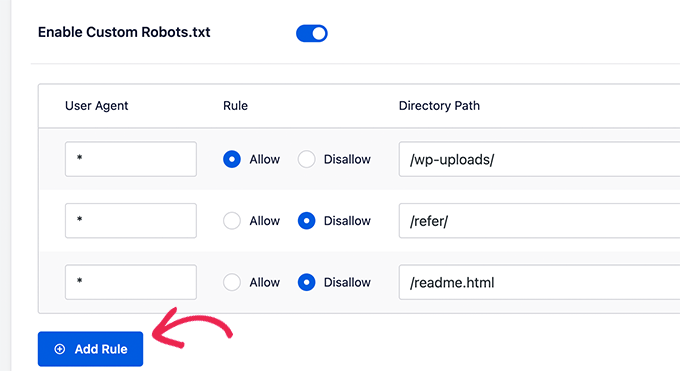

Najpierw musisz włączyć opcję edycji, klikając przełącznik „Enable Custom Robots.txt” na niebiesko.

Po włączeniu tego przełącznika można utworzyć własny plik robots.txt w WordPress.

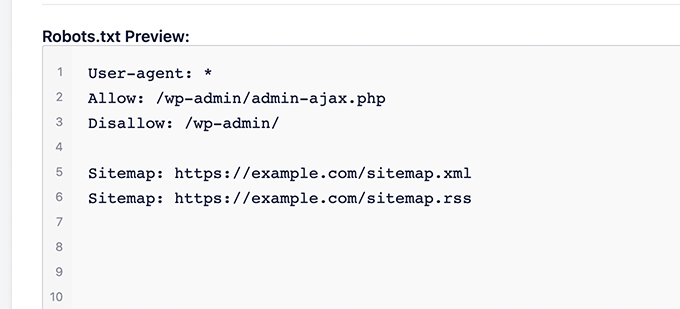

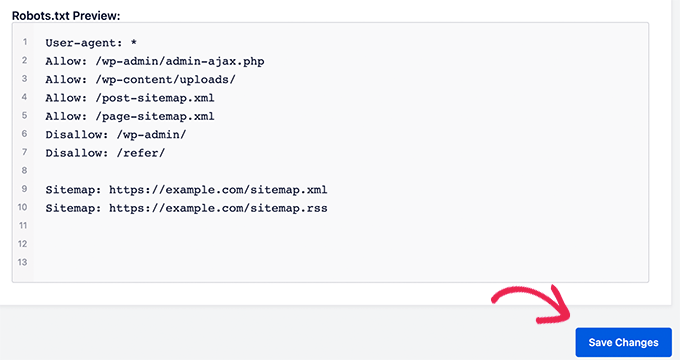

All in One SEO pokaże twój istniejący plik robots.txt w sekcji „Podgląd pliku robots.txt” na dole ekranu.

Ta wersja wyświetli domyślne reguły dodane przez WordPress.

Te domyślne reguły mówią wyszukiwarkom, by nie indeksowały rdzeni plików WordPressa, pozwalają botom indeksować całą treść i udostępniają im odnośnik do map witryn XML twojej witryny.

Teraz możesz dodać własne konfiguratory, aby ulepszyć swój plik robots.txt pod kątem SEO.

Aby dodać regułę, wpisz agenta użytkownika w polu „Agent użytkownika”. Użycie znaku * spowoduje zastosowanie reguły do wszystkich agentów użytkownika.

Następnie wybierz, czy chcesz „Zezwalać”, czy „Zezwalać” na indeksowanie przez wyszukiwarki.

Następnie wpisz nazwę pliku lub ścieżkę katalogu w polu „Ścieżka katalogu”.

Reguła zostanie automatycznie zastosowana do twojego pliku robots.txt. Aby dodać kolejną regułę, wystarczy kliknąć przycisk „Dodaj regułę”.

Zalecamy dodawanie reguł do momentu utworzenia idealnego formatu pliku robots.txt, który udostępniliśmy powyżej.

Twój konfigurator będzie wyglądał następująco.

Po zakończeniu nie zapomnij kliknąć przycisku „Zapisz zmiany”, aby zapisać twoje zmiany.

Metoda 2: Edycja pliku robots.txt przy użyciu WPCode

WPCode to potężna wtyczka fragmentów kodu, która pozwala łatwo i bezpiecznie dodawać własny kod do twojej witryny internetowej.

Zawiera również przydatną funkcję, która pozwala szybko edytować plik robots.txt.

Uwaga: Istnieje również darmowa wtyczka WPCode, ale nie zawiera ona funkcji edytora plików.

Pierwszą rzeczą, którą musisz zrobić, jest zainstalowanie wtyczki WPCode. Aby uzyskać instrukcje krok po kroku, zobacz nasz przewodnik dla początkujących, jak zainstalować wtyczkę WordPress.

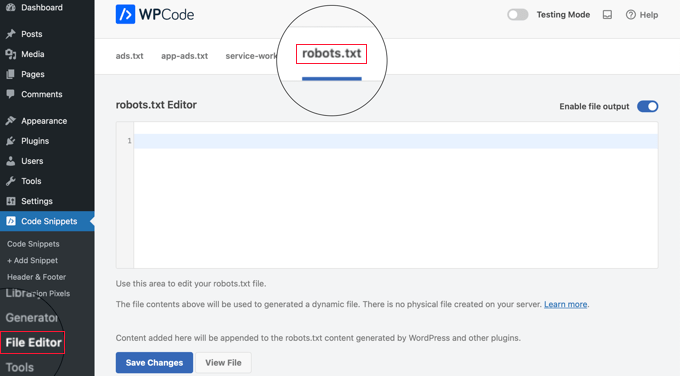

Po włączaniu należy przejść do strony WPCode ” Edytor plików. Tam wystarczy kliknąć kartę „robots.txt”, aby edytować plik.

Teraz możesz wkleić lub wpisać treść pliku robots.txt.

Po zakończeniu upewnij się, że kliknąłeś przycisk „Zapisz zmiany” u dołu strony, aby zapisać ustawienia.

Metoda 3: Ręczna edycja pliku Robots.txt przy użyciu FTP

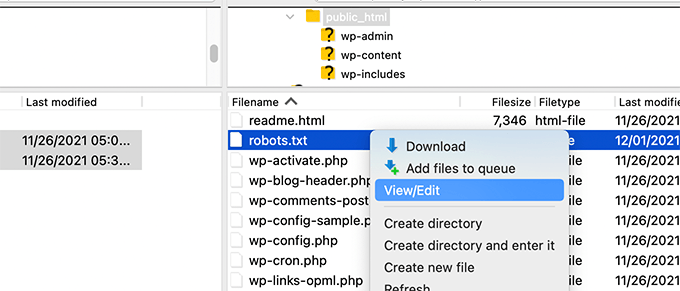

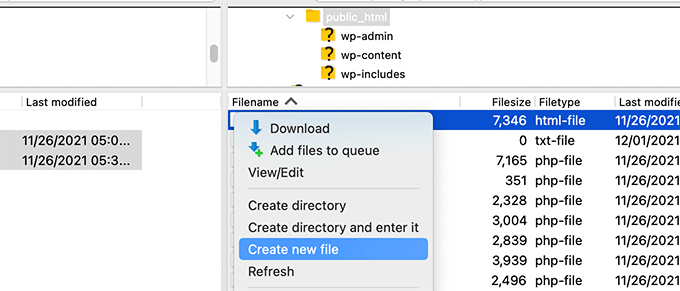

W przypadku tej metody konieczne będzie użycie klienta FTP do edycji pliku robots.txt. Alternatywnie możesz użyć menedżera plików dostarczonego przez twój hosting WordPress.

Wystarczy połączyć się z plikami twojej witryny internetowej WordPress za pomocą klienta FTP.

Po wejściu do środka będziesz mógł zobaczyć plik robots.txt w katalogu głównym twojej witryny internetowej.

Jeśli go nie widzisz, prawdopodobnie nie masz pliku robots.txt.

W takim przypadku możesz po prostu go utworzyć.

Robots.txt to zwykły plik tekstowy, co oznacza, że możesz pobrać go na swój komputer i edytować za pomocą dowolnego edytora tekstu, takiego jak Notatnik lub TextEdit.

Po zapisaniu zmian możesz przesłać plik robots.txt z powrotem do katalogu głównego witryny internetowej.

Jak przetestować twój plik robots.txt?

Po utworzeniu twojego pliku robots.txt zawsze warto przetestować go za pomocą narzędzia do testowania pliku robots.txt.

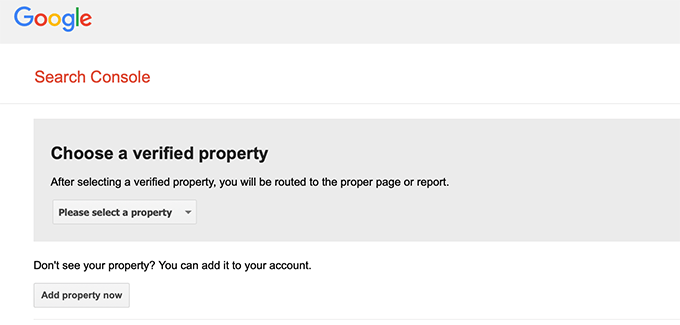

Istnieje wiele narzędzi do testowania pliku robots.txt, ale my zalecamy korzystanie z tego dostępnego w Google Search Console.

Po pierwsze, twoja witryna internetowa musi być odnośnikiem do Google Search Console. Jeśli jeszcze tego nie zrobiłeś, zapoznaj się z naszym przewodnikiem na temat dodawania Twojej witryny WordPress do Google Search Console.

Następnie można skorzystać z narzędzia do testowania robotów Google Search Console.

Wystarczy wybrać twój obiekt z rozwijanej listy.

Narzędzie automatycznie pobierze plik robots.txt twojej witryny internetowej i podświetli błędy i ostrzeżenia, jeśli takie znajdzie.

Przemyślenia końcowe

Celem optymalizacji twojego pliku robots.txt jest uniemożliwienie wyszukiwarkom indeksowania stron, które nie są publicznie dostępne. Na przykład strony w twoim katalogu wtyczek wp lub strony w katalogu administracyjnym WordPress.

Powszechnym mitem wśród ekspertów SEO jest to, że blokowanie kategorii, tagów i stron archiwalnych WordPress poprawi szybkość indeksowania i spowoduje szybsze indeksowanie i wyższą ocenę.

Nie jest to prawdą. Jest to również niezgodne z wytycznymi Google dla webmasterów.

Zalecamy przestrzeganie powyższego formatu pliku robots.txt w celu utworzenia pliku robots.txt dla twojej witryny internetowej.

Przewodniki ekspertów dotyczące korzystania z pliku robots.txt w WordPressie

Teraz, gdy już wiesz, jak zoptymalizować twój plik robots.txt, możesz chcieć zobaczyć kilka innych artykułów związanych z używaniem robots.txt w WordPress.

- Słowniczek: Robots.txt

- Jak ukryć stronę WordPress przed Google?

- Jak powstrzymać wyszukiwarki przed indeksowaniem witryny WordPress

- Jak trwale usunąć witrynę WordPress z Internetu?

- Jak łatwo ukryć (noindex) pliki PDF w WordPress?

- Jak naprawiono błąd „Googlebot nie może uzyskać dostępu do plików CSS i JS” w WordPress?

- Jak poprawnie skonfigurować All in One SEO dla WordPress (najlepszy przewodnik)

Mamy nadzieję, że ten artykuł pomógł ci dowiedzieć się, jak zoptymalizować twój plik robots.txt WordPress pod kątem SEO. Zachęcamy również do zapoznania się z naszym kompletnym przewodnikiem SEO WordPress i wyborem najlepszych narzędzi SEO WordPress, które pomogą ci rozwinąć twoją witrynę internetową.

If you liked this article, then please subscribe to our YouTube Channel for WordPress video tutorials. You can also find us on Twitter and Facebook.

Dennis Muthomi

I have to admit, I use the AIOSEO plugin but have always ignored the „Enable Custom Robots.txt” option because I didn’t want to mess anything up.

But I have read this article and I’m convinced it’s worth taking the time to optimize my site’s robots.txt file.

Amit Banerjee

If the whole template of robots.txt was given, it would have been of help.

WPBeginner Support

We did include the entire robots.txt

Admin

Moinuddin Waheed

Thanks for this informative post about robots.txt file.

I didn’t know that websites should maintain this file in order to have a control over Google bots that how should they crawl over our pages and posts.

for beginner websites just starting out, is there a need to have robots.txt file or is there a way like plugin which can a make a robots.txt file for our website?

WPBeginner Support

Most SEO plugins help with setting up the robots.txt for a new site to prevent bots from scrolling sections they shouuldn’t.

Admin

Jiří Vaněk

Thanks to this article, I checked the robots.txt file and added URL addresses with sitemaps. At the same time, I had other problematic lines there, which were revealed by the validator. I wasn’t familiar with sitemaps in robots.txt until now. Thanks.

WPBeginner Support

You’re welcome, glad our guide could help!

Admin

Stéphane

Hi,

Thanks for that post, it becomes clearer how to use the robots.txt file. On most websites that you find while looking for some advice regarding the robots.txt file, you can see that the following folders are explicitly excluded from crawling (for WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

I don’t really understand the reasons to exclude those folders (is there one actually?). What would be your take regarding that matter?

WPBeginner Support

It is mainly to prevent anything in those folders from showing as a result when a user searches for your site. As that is not your content it is not something most people would want to appear for the site’s results.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC show the coverage error for „Disallow: /wp-admin/” Is this wrong?

WPBeginner Support

For most sites, you do not want anything from your wp-admin to appear as a search result so it is fine and expected to receive the coverage area when you deny Google the ability to scan your wp-admin.

Admin

Hansini

I am creating my robots.txt manually as you instructed for my WordPress site.

I have one doubt. when I write User-Agent: * won’t it allow another spamming robot to access my site?

Should I write User-Agent: * or User-Agent: Googlebot.?

WPBeginner Support

The User-Agent line is setting the rules that all robots should follow on your site, if you specify a specific bot on that line it would be setting rules for that specific bot and none of the others.

Admin

Nishant

What should we write to make google index my post?

WPBeginner Support

For having your site listed, you would want to take a look at our article below:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

should we also disallow /wp-content/themes/ ?

It is appearing in the search result when I run the command site:abcdef.com in google search

WPBeginner Support

You would not want to worry about blocking your themes folder and as you write SEO-friendly content you should no longer see the themes as a search result.

Admin

Salem

HI, What’s means ” Disallow: /readme.html & Disallow: /refer/ ” ?

WPBeginner Support

That means you’re telling search engines to not look at any referral links or the readme.html file.

Admin

sean

Hi, what are the pros and cons of blocking wp-content/uploads

Thank you

WPBeginner Support

If you block your uploads folder then search engines would not normally crawl your uploaded content like images.

Admin

Piyush

thanks for solve my problem

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Sir i m very confused about robot.txt many time i submitted site map in blogger but the after 3,4 days coming the same issue what is the exactly robot.txt.. & how submit that please guide me

WPBeginner Support

It would depend on your specific issue, you may want to take a look at our page below:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

If I no index a url or page using robots.txt file, does google shows any error in search console?

WPBeginner Support

No, Google will not list the page but if the page is listed it will not show an error.

Admin

Bharat

Hi

I have a question

i receive google search console coverage issue warning for blocked by robots.txt

/wp-admin/widgets.php

My question is, can i allow for wp-admin/widgets.php to robots.txt and this is safe?

WPBeginner Support

IF you wanted to you can but that is not a file that Google needs to crawl.

Admin

Anthony

Hi there, I’m wondering if you should allow: /wp-admin/admin-ajax.php?

WPBeginner Support

Normally, yes you should.

Admin

Jaira

May I know why you should allow /wp-admin/admin-ajax.php?

WPBeginner Support

It is used by different themes and plugins to appear correctly for search engines.

Amila

Hello! I really like this article and as I’m a beginner with all this crawling stuff I would like to ask something in this regard. Recently, Google has crawled and indexed one of my websites on a really terrible way, showing the pages in search results which are deleted from the website. The website didn’t have discouraged search engine from indexing in the settings of WordPress at the beginning, but it did later after Google showed even 3 more pages in the search results (those pages also doesn’t exist) and I really don’t understand how it could happen with „discourage search engine from indexing” option on. So, can the Yoast method be helpful and make a solution for my website to Google index my website on the appropriate way this time? Thanks in advance!

WPBeginner Support

The Yoast plugin should be able to assist in ensuring the pages you have are indexed properly, there is a chance before you discouraged search engines from crawling your site your page was cached.

Admin

Amila

Well yes and from all pages, it cached the once who doesn’t exist anymore. Anyway, as the current page is on „discourage” setting on, is it better to keep it like that for now or to uncheck the box and leave the Google to crawl and index it again with Yoast help? Thanks! With your articles, everything became easier!

WPBeginner Support

You would want to have Google recrawl your site once it is set up how you want.

Pradhuman Kumar

Hi I loved the article, very precise and perfect.

Just a small suggestion kindly update the image ROBOTS.txt tester, as Google Console is changed and it would be awesome if you add the link to check the robots.txt from Google.

WPBeginner Support

Thank you for the feedback, we’ll be sure to look into updating the article as soon as we are able.

Admin

Kamaljeet Singh

My blog’s robots.txt file was:

User-Agent: *

crawl-delay: 10

After reading this post, I have changed it into your recommended robots.txt file. Is that okay that I removed crawl-delay

WPBeginner Support

It should be fine, crawl-delay tells search engines to slow down how quickly to crawl your site.

Admin

reena

Very nicely described about robot.text, i am very happy

u r very good writer

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

What is Disallow: /refer/ page ? I get a 404, is this a hidden wp file?

Editorial Staff

We use /refer/ to redirect to various affiliate links on our website. We don’t want those to be indexed since they’re just redirects and not actual content.

Admin

Sagar Arakh

Thank you for sharing. This was really helpful for me to understand robots.txt

I have updated my robots.txt to the ideal one you suggested. i will wait for the results now

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Very helpful article. Thank you very much.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Thanks for share this useful information about us.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

thanks for update information for me. Your article was good for Robot txt. file. It gave me a piece of new information. thanks and keep me updating with new ideas.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Thanks , I added robots.txt in WordPress .Very good article

WPBeginner Support

Thank you, glad our article was helpful

Admin