WPBeginnerでは、これまで何百万人ものユーザーに、ウェブサイトを検索用に最適化し、オーガニックなトラフィックを増やす方法を指導してきました。私たちは、初心者が見落としがちなSEOの側面の1つに、検索エンジンがあなたのウェブサイトを発見し、クロールし、インデックスするのを助けるrobots.txtファイルがあることを発見しました。

このシンプルなテキストファイルは、検索エンジンのボットに対して、サイトのどの部分にアクセスし、どの部分を残すかを指示する役割を果たします。

robots.txtファイルを最適化することで、検索エンジンが最も重要なコンテンツのクロールとインデックスに集中するようにすることができ、同時に、検索エンジンがウェブサイトのあまり重要でない領域でリソースを浪費するのを防ぐことができます。

この記事では、WordPressウェブサイトに完璧に最適化されたrobots.txtファイルを作成し、SEOの可能性を最大化するためのヒントを紹介します。

Robots.txtファイルとは何ですか?

Robots.txtは、サイトオーナーが検索エンジンのボットにサイトのページをクロールしてインデックスする方法を伝えるために作成できるテキストファイルです。

通常、サイトのルートディレクトリ(メインフォルダとも呼ばれる)に保存されます。robots.txtファイルの基本的な書式は次のようになります:

1 2 3 4 5 6 7 | User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap] |

特定のURLを許可または不許可にする指示を複数行用意し、複数のサイトマップを追加することができる。URLを許可しない場合、検索エンジンのボットはそのURLをクロールする権限がないとみなします。

robots.txtの例を以下に示す:

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml |

上記のrobots.txtの例では、検索エンジンがWordPressのアップロードフォルダー内のファイルをクロールし、インデックスすることを許可しています。

その後、検索ボットがプラグインやWordPressの管理フォルダーをクロールしたりインデックス化したりするのを禁止した。

最後に、XMLサイトマップのURLをプロバイダーに提供しました。

WordPressサイトにRobots.txtファイルは必要か?

robots.txtファイルがなくても、検索エンジンはあなたのサイトをクロールし、インデックスします。しかし、どのページやフォルダーをクロールしてはいけないかを指定することはできません。

ブログを始めたばかりでコンテンツが少ないうちは、この影響はあまりないだろう。

しかし、サイトが成長し、コンテンツが増えるにつれて、クロールやインデックスされる方法をもっとコントロールしたいと思うようになるでしょう。

その理由はこうだ。

検索ボットはサイトごとにクロール枠を持っています。

つまり、1回のクロールでクロールするページ数は決まっている。サイトのすべてのページをクロールし終わる前にクロール予算を使い切った場合、次のセッションでクロールを再開します。

これはサイトのインデックス率を低下させる可能性がある。

WordPressの管理ページ、プラグインファイル、テーマフォルダなど、検索ボットが不要なページをクロールしようとしないようにすることで、この問題を解決することができます。

不要なページを除外することで、クロール枠を節約することができます。これにより、検索エンジンはサイト内のさらに多くのページをクロールし、できるだけ早くインデックスすることができます。

robots.txtファイルを使用するもう一つの良い理由は、検索エンジンがあなたのサイトの投稿やページをインデックスするのを止めたい場合です。

これは、一般の人々からコンテンツを非表示にする最も安全な方法ではありませんが、検索結果にコンテンツが表示されるのを防ぐのに役立ちます。

理想的なRobots.txtファイルとは?

多くの人気ブログは、非常にシンプルなrobots.txtファイルを使用しています。そのコンテンツは、特定のサイトのニーズによって異なる場合があります:

1 2 3 4 5 | User-agent: *Disallow:Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

このrobots.txtファイルは、すべてのボットにすべてのコンテンツのインデックスを許可し、ウェブサイトのXMLサイトマップへのリンクを提供します。

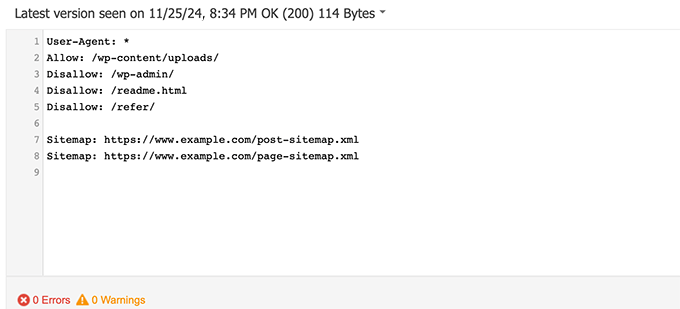

WordPressサイトでは、robots.txtファイルに以下のルールを記述することをお勧めします:

1 2 3 4 5 6 7 8 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

これは、検索ボットにWordPressの画像とファイルをすべてインデックスするように指示します。WordPressの管理エリア、readmeファイル、クロークされたアフィリエイトリンクを検索ボットがインデックスしないようにします。

robots.txtファイルにサイトマップを追加することで、Googleボットがサイト上のすべてのページを見つけやすくなります。

理想的なrobots.txtファイルがどのようなものかわかったところで、WordPressでrobots.txtファイルを作成する方法を見てみましょう。

WordPressでRobots.txtファイルを作成する方法

WordPressでrobots.txtファイルを作成するには、2つの方法があります。自分に合った方法を選んでください。

方法1:All In One SEOを使ってRobots.txtファイルを編集する

All In One SEOは、AIOSEOとしても知られ、300万以上のサイトで使用されている、市場で最高のWordPress SEOプラグインです。使い方は簡単で、robots.txtファイルジェネレータが付属しています。

さらに詳しく知りたい方は、AIOSEOのレビューをご覧ください。

AIOSEOプラグインがすでにインストールされていない場合は、WordPressプラグインのインストール方法のステップバイステップガイドをご覧ください。

注: AIOSEOの無料版もあり、この機能を備えています。

プラグインをインストールして有効化したら、WordPressの管理エリアから直接robots.txtファイルを作成・編集することができます。

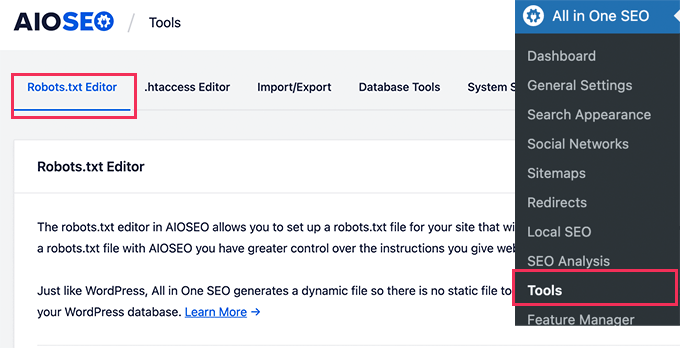

All In One SEO ” Toolsでrobots.txtファイルを編集してください。

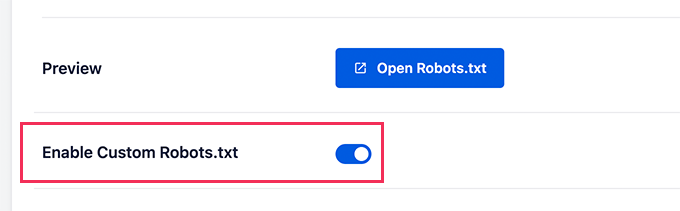

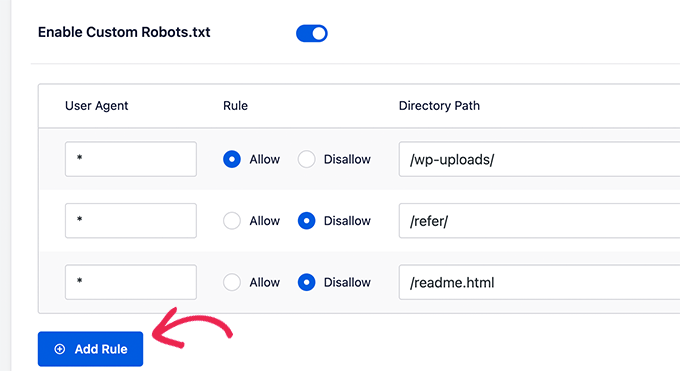

まず、’Enable Custom Robots.txt’を青にクリックして編集オプションをオンにする必要があります。

このトグルをオンにすると、WordPressでカスタムのrobots.txtファイルを作成できます。

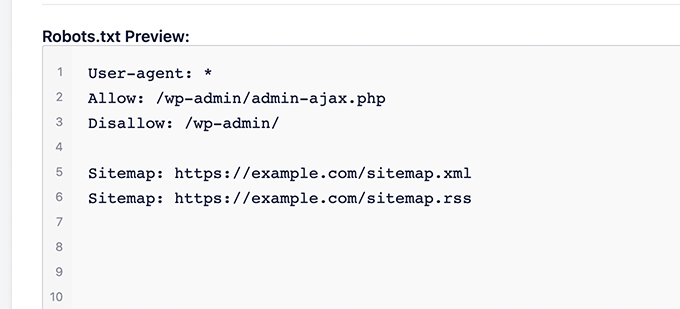

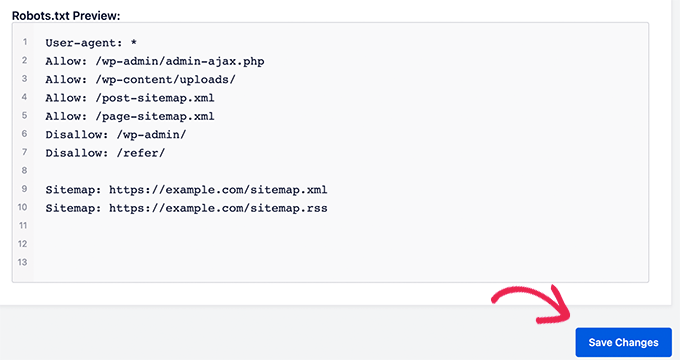

All In One SEOは、画面下部の「Robots.txtプレビュー」に既存のrobots.txtファイルを表示します。

このバージョンでは、WordPressによって追加された初期設定が表示されます。

これらの初期設定は、検索エンジンにWordPressのコアファイルをクロールしないように指示し、ボットがすべてのコンテンツをインデックスすることを権限がありません。

SEOのためのrobots.txtを改善するために、独自のカスタムルールを追加できるようになりました。

ルールを追加するには、「ユーザーエージェント」フィールドにユーザーエージェントを入力します。を使用すると、すべてのユーザーエージェントにルールが適用されます。

次に、検索エンジンのクロールを「許可する」か「許可しない」かを選択します。

次に、「ディレクトリパス」フィールドにファイル名またはディレクトリパスを入力する。

ルールは自動的にrobots.txtに適用されます。別のルールを追加するには、「ルールを追加」ボタンをクリックしてください。

上記で紹介した理想的なrobots.txtフォーマットを作成するまで、ルールを追加することをお勧めする。

カスタマイザーは次のようになる。

変更が完了したら、「変更を保存」ボタンをクリックして変更を保存することを忘れないでください。

方法2:WPCodeを使ってRobots.txtファイルを編集する

WPCodeは、あなたのサイトに簡単かつ安全にカスタマイザーコードを追加できる強力なコードスニペットプラグインです。

また、robots.txtファイルを素早く編集できる便利な機能もあります。

注: WPCode Freeプラグインもありますが、ファイルエディター機能は含まれていません。

最初に行う必要があるのは、WPCodeプラグインのインストールです。ステップバイステップの手順については、WordPressプラグインのインストール方法についての初心者ガイドをご覧ください。

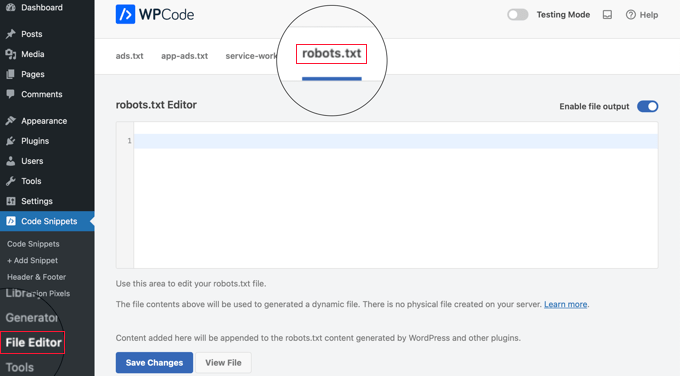

有効化した後、WPCode ” ファイルエディターページに移動する必要があります。そこで「robots.txt」タブをクリックし、ファイルを編集してください。

ここで、robots.txtファイルのコンテンツを貼り付けるか、入力する。

設定が完了したら、ページ下部の「変更を保存」ボタンをクリックして、設定を保存してください。

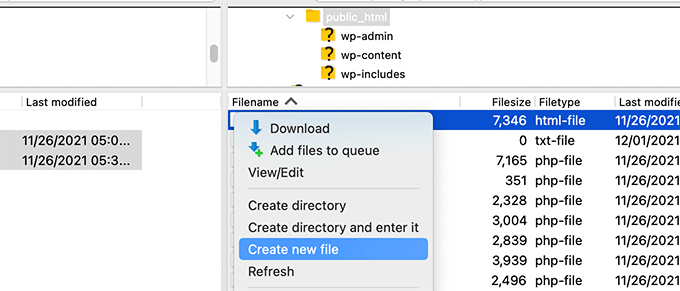

方法3:FTPを使ってRobots.txtファイルを手動で編集する

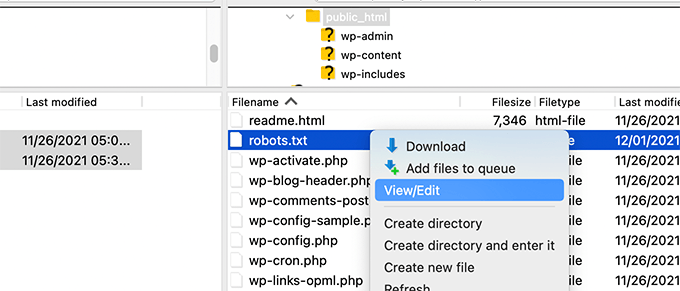

この方法では、FTPクライアントを使用してrobots.txtファイルを編集する必要があります。または、WordPressホスティングサービスが提供するファイルマネージャーを使用することもできます。

FTPクライアントを使用してWordPressサイトのファイルに接続するだけです。

中に入ると、サイトのルート・フォルダーにあるrobots.txtファイルを見ることができる。

もし見当たらない場合は、robots.txtファイルがない可能性が高い。

その場合は、そのまま作成すればいい。

Robots.txtはプレーンテキストファイルなので、コンピューターにダウンロードして、メモ帳やテキストエディットなどのプレーンテキストエディターを使って編集することができます。

変更を保存したら、robots.txtファイルをサイトのルートフォルダーにアップロードします。

Robots.txtファイルのテスト方法

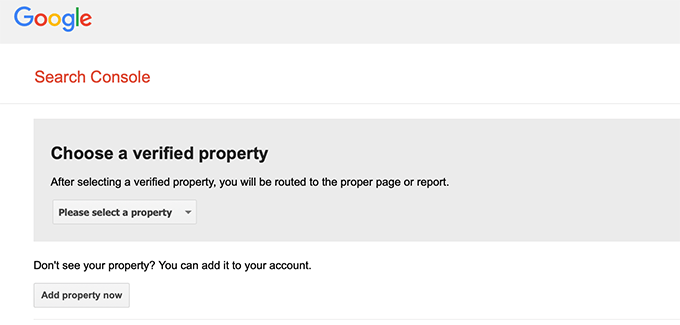

robots.txtファイルを作成したら、robots.txtテスターツールを使ってテストすることをお勧めします。

robots.txtのテスターツールはたくさんありますが、Google Search Console内のものを使うことをお勧めします。

まず、サイトをGoogle Search Consoleにリンクさせる必要があります。まだの方は、WordPressサイトをGoogle Search Consoleに追加する方法をご覧ください。

次に、Google Search Consoleのロボットテストツールを使用します。

ドロップダウンリストよりご希望の物件をお選びください。

このツールは、あなたのサイトのrobots.txtファイルを自動的に取得し、エラーや警告が見つかった場合にハイライト表示します。

最終的なフィードバック

robots.txtファイルを最適化する目的は、一般に公開されていないページを検索エンジンがクロールできないようにすることです。例えば、wp-pluginsフォルダ内のページやWordPress管理フォルダ内のページなどです。

SEOの専門家の間でよく言われているのは、WordPressのカテゴリー、タグ、アーカイブページをブロックすれば、クロール率が向上し、インデックスが速くなり、ランキングが上がるという俗説だ。

これは真実ではない。Googleのウェブマスター向けガイドラインにも反している。

上記のrobots.txtフォーマットに従って、あなたのサイトのrobots.txtファイルを作成することをお勧めします。

WordPressでRobots.txtを使うためのエキスパートガイド

robots.txtファイルを最適化する方法がわかったところで、WordPressでrobots.txtを使用することに関連する他の投稿もご覧ください。

- 用語集Robots.txt

- WordPressのページをGoogleから非表示にする方法

- WordPressサイトを検索エンジンにクロールさせない方法

- WordPressサイトをインターネットから永久に削除する方法

- WordPressでPDFファイルを簡単に非表示(インデックスなし)にする方法

- WordPressの「Googlebot cannot access CSS and JS files」エラーを修正する方法

- WordPressのSEOをすべて正しく設定する方法(究極のガイド)

WordPressのrobots.txtファイルをSEOのために最適化する方法について、この投稿がお役に立てば幸いです。また、究極のWordPress SEOガイドと、サイトを成長させる最高のWordPress SEOツールのエキスパートピックもご覧ください。

If you liked this article, then please subscribe to our YouTube Channel for WordPress video tutorials. You can also find us on Twitter and Facebook.

Amit Banerjee

If the whole template of robots.txt was given, it would have been of help.

WPBeginner Support

We did include the entire robots.txt

Admin

Moinuddin Waheed

Thanks for this informative post about robots.txt file.

I didn’t know that websites should maintain this file in order to have a control over Google bots that how should they crawl over our pages and posts.

for beginner websites just starting out, is there a need to have robots.txt file or is there a way like plugin which can a make a robots.txt file for our website?

WPBeginner Support

Most SEO plugins help with setting up the robots.txt for a new site to prevent bots from scrolling sections they shouuldn’t.

Admin

Jiří Vaněk

Thanks to this article, I checked the robots.txt file and added URL addresses with sitemaps. At the same time, I had other problematic lines there, which were revealed by the validator. I wasn’t familiar with sitemaps in robots.txt until now. Thanks.

WPBeginner Support

You’re welcome, glad our guide could help!

Admin

Stéphane

Hi,

Thanks for that post, it becomes clearer how to use the robots.txt file. On most websites that you find while looking for some advice regarding the robots.txt file, you can see that the following folders are explicitly excluded from crawling (for WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

I don’t really understand the reasons to exclude those folders (is there one actually?). What would be your take regarding that matter?

WPBeginner Support

It is mainly to prevent anything in those folders from showing as a result when a user searches for your site. As that is not your content it is not something most people would want to appear for the site’s results.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC show the coverage error for “Disallow: /wp-admin/” Is this wrong?

WPBeginner Support

For most sites, you do not want anything from your wp-admin to appear as a search result so it is fine and expected to receive the coverage area when you deny Google the ability to scan your wp-admin.

Admin

Hansini

I am creating my robots.txt manually as you instructed for my WordPress site.

I have one doubt. when I write User-Agent: * won’t it allow another spamming robot to access my site?

Should I write User-Agent: * or User-Agent: Googlebot.?

WPBeginner Support

The User-Agent line is setting the rules that all robots should follow on your site, if you specify a specific bot on that line it would be setting rules for that specific bot and none of the others.

Admin

Nishant

What should we write to make google index my post?

WPBeginner Support

For having your site listed, you would want to take a look at our article below:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

should we also disallow /wp-content/themes/ ?

It is appearing in the search result when I run the command site:abcdef.com in google search

WPBeginner Support

You would not want to worry about blocking your themes folder and as you write SEO-friendly content you should no longer see the themes as a search result.

Admin

Salem

HI, What’s means ” Disallow: /readme.html & Disallow: /refer/ ” ?

WPBeginner Support

That means you’re telling search engines to not look at any referral links or the readme.html file.

Admin

sean

Hi, what are the pros and cons of blocking wp-content/uploads

Thank you

WPBeginner Support

If you block your uploads folder then search engines would not normally crawl your uploaded content like images.

Admin

Piyush

thanks for solve my problem

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Sir i m very confused about robot.txt many time i submitted site map in blogger but the after 3,4 days coming the same issue what is the exactly robot.txt.. & how submit that please guide me

WPBeginner Support

It would depend on your specific issue, you may want to take a look at our page below:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

If I no index a url or page using robots.txt file, does google shows any error in search console?

WPBeginner Support

No, Google will not list the page but if the page is listed it will not show an error.

Admin

Bharat

Hi

I have a question

i receive google search console coverage issue warning for blocked by robots.txt

/wp-admin/widgets.php

My question is, can i allow for wp-admin/widgets.php to robots.txt and this is safe?

WPBeginner Support

IF you wanted to you can but that is not a file that Google needs to crawl.

Admin

Anthony

Hi there, I’m wondering if you should allow: /wp-admin/admin-ajax.php?

WPBeginner Support

Normally, yes you should.

Admin

Jaira

May I know why you should allow /wp-admin/admin-ajax.php?

WPBeginner Support

It is used by different themes and plugins to appear correctly for search engines.

Amila

Hello! I really like this article and as I’m a beginner with all this crawling stuff I would like to ask something in this regard. Recently, Google has crawled and indexed one of my websites on a really terrible way, showing the pages in search results which are deleted from the website. The website didn’t have discouraged search engine from indexing in the settings of WordPress at the beginning, but it did later after Google showed even 3 more pages in the search results (those pages also doesn’t exist) and I really don’t understand how it could happen with “discourage search engine from indexing” option on. So, can the Yoast method be helpful and make a solution for my website to Google index my website on the appropriate way this time? Thanks in advance!

WPBeginner Support

The Yoast plugin should be able to assist in ensuring the pages you have are indexed properly, there is a chance before you discouraged search engines from crawling your site your page was cached.

Admin

Amila

Well yes and from all pages, it cached the once who doesn’t exist anymore. Anyway, as the current page is on “discourage” setting on, is it better to keep it like that for now or to uncheck the box and leave the Google to crawl and index it again with Yoast help? Thanks! With your articles, everything became easier!

WPBeginner Support

You would want to have Google recrawl your site once it is set up how you want.

Pradhuman Kumar

Hi I loved the article, very precise and perfect.

Just a small suggestion kindly update the image ROBOTS.txt tester, as Google Console is changed and it would be awesome if you add the link to check the robots.txt from Google.

WPBeginner Support

Thank you for the feedback, we’ll be sure to look into updating the article as soon as we are able.

Admin

Kamaljeet Singh

My blog’s robots.txt file was:

User-Agent: *

crawl-delay: 10

After reading this post, I have changed it into your recommended robots.txt file. Is that okay that I removed crawl-delay

WPBeginner Support

It should be fine, crawl-delay tells search engines to slow down how quickly to crawl your site.

Admin

reena

Very nicely described about robot.text, i am very happy

u r very good writer

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

What is Disallow: /refer/ page ? I get a 404, is this a hidden wp file?

Editorial Staff

We use /refer/ to redirect to various affiliate links on our website. We don’t want those to be indexed since they’re just redirects and not actual content.

Admin

Sagar Arakh

Thank you for sharing. This was really helpful for me to understand robots.txt

I have updated my robots.txt to the ideal one you suggested. i will wait for the results now

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Very helpful article. Thank you very much.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Thanks for share this useful information about us.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

thanks for update information for me. Your article was good for Robot txt. file. It gave me a piece of new information. thanks and keep me updating with new ideas.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Thanks , I added robots.txt in WordPress .Very good article

WPBeginner Support

Thank you, glad our article was helpful

Admin