Robots.txt è un file di testo che permette a un sito web di fornire istruzioni ai bot che effettuano il web-crawling.

Indica ai motori di ricerca come Google a quali parti del sito web possono o non possono accedere durante l’indicizzazione del sito.

Questo rende il robots.txt uno strumento potente per la SEO e può essere utilizzato anche per garantire che determinate pagine non compaiano nei risultati della ricerca di Google.

Come funziona il file Robots.txt?

Robots.txt è un file di testo che si può creare per indicare ai bot dei motori di ricerca quali pagine del sito web devono essere scansionate e indicizzate. Di norma viene memorizzato nella directory principale del sito web.

I motori di ricerca come Google utilizzano i web crawler, talvolta chiamati web robot, per archiviare e classificare i siti web. La maggior parte dei bot è configurata per cercare un file robots.txt sul server prima di leggere qualsiasi altro file dal sito web. Il bot esegue questa operazione per vedere se il proprietario di un sito web ha dato istruzioni speciali sul crawling e l’indicizzazione del sito.

Il file robots.txt contiene una serie di istruzioni che richiedono al bot di ignorare specifici file o directory. Ciò può avvenire per motivi di privacy o perché il proprietario del sito web ritiene che il contenuto di tali file e directory sia irrilevante per la categorizzazione del sito web nei motori di ricerca.

Ecco un esempio di file robots.txt:

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml |

In questo esempio, l’asterisco “*” dopo “User-Agent” specifica che le istruzioni sono per tutti i motori di ricerca.

Quindi, permettiamo ai motori di ricerca di eseguire il crawling e l’indicizzazione dei file nella cartella uploader di WordPress. Poi, non consentiamo ai motori di ricerca di effettuare il crawling e l’indicizzazione dei plugin e delle cartelle di amministrazione di WordPress.

Si noti che se non si disconosce un URL, i bot dei motori di ricerca penseranno di poterlo indicizzare.

Infine, abbiamo fornito l’URL della nostra sitemap XML.

Come creare un file Robots.txt in WordPress

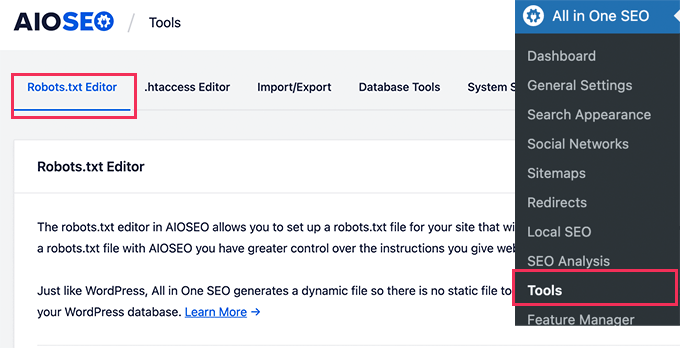

Il modo più semplice per creare un file robots.txt è utilizzare All in One SEO. È il miglior plugin SEO per WordPress presente sul mercato ed è dotato di un generatore di file robots.txt facile da usare.

Un altro strumento che si può utilizzare è WPCode, un potente plugin di snippets di codice che consente di aggiungere codice personalizzato al sito web in modo semplice e sicuro. La versione Pro include una comoda caratteristica che consente di modificare rapidamente il file robots.txt.

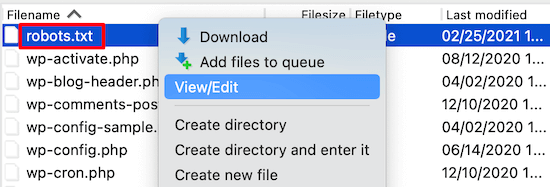

Tuttavia, se si ha familiarità con il codice, è possibile creare il file robots.txt manualmente. Per modificare il file robots.txt è necessario utilizzare un client FTP. In alternativa, potete utilizzare il file manager fornito dal vostro hosting WordPress.

Per maggiori dettagli sulla creazione di un file robots.txt, consultate la nostra guida su come ottimizzare il robots.txt di WordPress per la SEO.

Come utilizzare Robots.txt per impedire ai motori di ricerca di effettuare il crawling di un sito

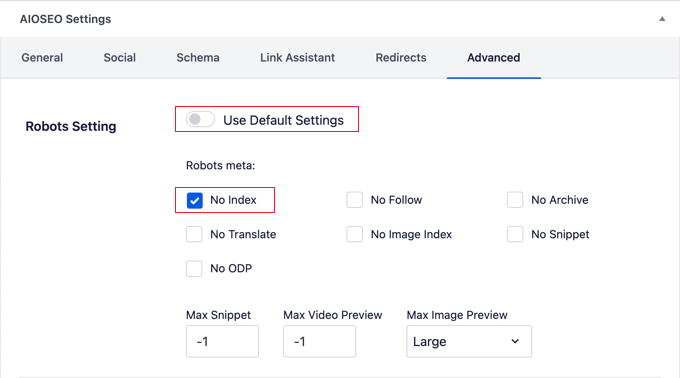

I motori di ricerca sono la principale fonte di traffico per la maggior parte dei siti web. Tuttavia, ci sono alcuni motivi per cui potreste voler scoraggiare i motori di ricerca dall’indicizzare il vostro sito.

Ad esempio, se state ancora costruendo il vostro sito web, non vorrete che compaia nei risultati della ricerca. Lo stesso vale per i blog privati e le intranet aziendali.

È possibile utilizzare le regole di disconoscimento nel file robots.txt per chiedere ai motori di ricerca di non indicizzare l’intero sito web o solo alcune pagine di ricerca. Troverete istruzioni dettagliate nella nostra guida su come impedire ai motori di ricerca di effettuare il crawling di un sito WordPress.

È possibile utilizzare strumenti come All in One SEO per aggiungere automaticamente queste regole al file robots.txt.

È importante notare che non tutti i bot rispettano un file robots.txt. Alcuni bot maligni leggono addirittura il file robots.txt per individuare i file e le directory da colpire per primi.

Inoltre, anche se un file robots.txt istruisce i bot a ignorare pagine specifiche del sito, tali pagine possono comunque comparire nei risultati della ricerca se sono collegate ad altre pagine crawlate.

Speriamo che questo articolo vi abbia aiutato ad approfondire il tema del robots.txt in WordPress. Potreste anche consultare il nostro elenco di letture aggiuntive qui sotto per trovare articoli correlati su suggerimenti, trucchi e idee utili per WordPress.

Se questo articolo vi è piaciuto, iscrivetevi al nostro canale YouTube per le esercitazioni video su WordPress. Potete trovarci anche su Twitter e Facebook.

Additional Reading

- Come ottimizzare il file Robots.txt di WordPress per la SEO

- SEO

- Come aggiungere il vostro sito WordPress a Google Search Console

- Cos’è una Sitemap XML? Come creare una Sitemap in WordPress

- Come impedire ai motori di ricerca di effettuare il crawling di un sito WordPress

- Come nascondere una pagina di WordPress da Google (4 metodi)