Imaginez que vous ayez travaillé dur pour écrire une histoire ou un article de qualité, et que vous trouviez uniquement quelqu’un d’autre qui s’en réclame. C’est ce qui arrive lorsque des personnes volent le contenu de votre site.

Le vol de contenu, ou “scraping”, est un gros problème pour les propriétaires de sites web. Ces personnes sont des voleurs qui copient votre travail, l’utilisent sur leurs propres sites et prétendent même parfois que c’est le leur. Cela peut être très frustrant et injuste.

Dans cet article, nous verrons ce qu’est le scraping de contenu de blog, comment vous pouvez réduire et prévenir le scraping de contenu, et même comment tirer profit des scrapers de contenu pour votre propre bénéfice.

Qu’est-ce que le scraping de contenu de blog sous WordPress ?

On parle de scraping de contenu de blog lorsque le contenu est prélevé sur de nombreuses sources et republié sur un autre site. En général, cela se fait automatiquement via le flux RSS de votre blog.

Malheureusement, il est très facile et très courant de se faire voler le contenu de son blog WordPress de cette manière. Si cela vous est arrivé, vous comprenez à quel point cela peut être stressant et frustrant.

Parfois, votre contenu sera simplement copié et collé directement sur un autre site, y compris votre mise en forme, vos images, vos vidéos, etc.

D’autres fois, votre contenu sera repris avec attribution et un lien vers votre site, mais sans votre droit. Bien que cela puisse aider votre référencement, il est préférable que votre contenu original soit hébergé uniquement sur votre site.

Pourquoi les “content scrapers” volent-ils du contenu ?

Certaines de nos utilisatrices/utilisateurs nous ont demandé pourquoi les “scrapers” volent du contenu. En général, la principale motivation du vol de contenu est de profiter de votre dur labeur :

- Commission d’affiliation : Des marketing d’affiliation malhonnêtes peuvent utiliser votre contenu pour amener du trafic sur leur site via les moteurs de recherche afin de commander leurs produits de niche.

- Génération de prospects : Les auteurs/autrices et les agents immobiliers peuvent payer quelqu’un pour ajouter du contenu et gagner en autorité dans leur communauté sans se rendre compte qu’il s’agit d’un contenu récupéré à partir d’autres sources.

- Recettes d’annonces : Les propriétaires de blogs peuvent récupérer du contenu pour créer un centre de connaissances dans un certain créneau “pour le bien de la communauté” et ensuite inonder le site de publicités.

Est-il possible d’empêcher complètement le “content scraping” ?

Dans cet article, nous allons vous afficher quelques mesures que vous pouvez prendre pour réduire et prévenir le scraping de contenu. Mais malheureusement, il n’existe aucun moyen d’arrêter complètement un voleur déterminé.

C’est pourquoi nous avons terminé cet article par une section sur la manière dont vous pouvez tirer parti des racleurs de contenu. Bien qu’il ne soit pas toujours possible d’arrêter un voleur, vous pouvez peut-être gagner du trafic et des revenus grâce au contenu qu’il vous a volé.

Que faire lorsque vous découvrez que quelqu’un a récupéré votre contenu ?

Étant donné qu’il n’est pas possible d’arrêter complètement les scrapers, vous pourriez un jour découvrir que quelqu’un utilise du contenu qu’il a volé sur votre blog. Vous vous demandez peut-être ce qu’il faut faire dans ce cas.

Voici quelques approches que les gens adoptent lorsqu’ils ont affaire à des scrappeurs de contenu :

- Ne rien faire : Vous pouvez passer beaucoup de temps à lutter contre les “scrapers”, c’est pourquoi certains blogueurs populaires décident de ne rien faire. Google considère déjà les sites connus comme des auteurs/autrices, mais ce n’est pas le cas des sites plus petits. Cette approche n’est donc pas toujours la meilleure, à notre avis.

- Retrait: vous pouvez contacter le scraper et lui demander de retirer le contenu. S’il refuse, vous envoyez alors une notification de retrait. Vous pouvez apprendre comment dans notre guide sur la façon de trouver et de retirer facilement du contenu volé dans WordPress.

- Profiter de l’avantage : Alors que nous travaillons activement à faire retirer le contenu activé de WPBeginner, nous utilisons également quelques techniques pour obtenir du trafic et gagner de l’argent grâce aux scrapers. Vous pouvez apprendre comment dans la section “Tirer profit des racleurs de contenu” ci-dessous.

Ceci étant dit, voyons comment empêcher le scraping de blog sur WordPress. Comme il s’agit d’un guide complet, nous avons inclus une table des matières pour faciliter la navigation :

1. Copyright ou marque déposée pour le nom et le logo de votre blog

Les lois sur les marques et les droits d’auteur protègent vos droits de propriété intellectuelle, votre marque et votre entreprise contre de nombreux problèmes juridiques. Cela inclut le plagiat et l’utilisation illégale de votre matériel protégé par le droit d’auteur ou du nom et du logo de votre marque.

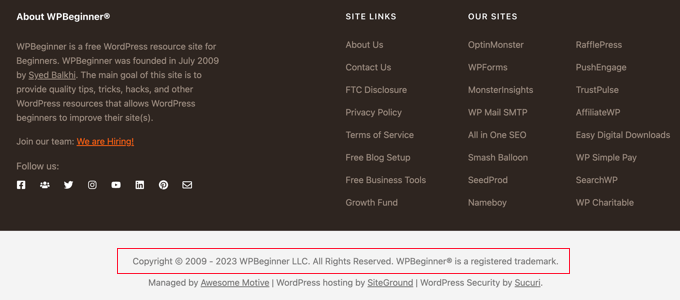

Vous devez afficher clairement une notification de copyright sur votre site. Bien que le contenu de votre site soit automatiquement couvert par les lois sur le copyright, l’affichage d’une notification permet de faire savoir que votre contenu est protégé par le copyright et qu’ils ne peuvent pas utiliser vos propriétés protégées à des fins commerciales.

Par exemple, vous pouvez ajouter une notification de copyright avec une date dynamique dans votre pied de page WordPress. Ainsi, votre notification de copyright restera à jour.

Cela peut dissuader certaines utilisatrices/utilisateurs de le voler. Cela vous aidera également au cas où vous devriez envoyer une lettre de cessation et de désistement ou déposer une plainte auprès de la DCMA pour retirer le contenu volé.

Vous pouvez également demander l’Inscription d’un droit d’auteur en ligne. Cette procédure peut être compliquée, mais heureusement, il existe des services juridiques peu coûteux qui peuvent aider les petites entreprises et les particuliers.

Découvrez comment faire dans notre guide sur les marques et les droits d’auteur pour le nom et le logo de votre blog.

2. Rendre votre flux RSS plus difficile à gratter

Étant donné que le scraping de contenu de blog se fait généralement de manière automatique via le flux RSS de votre blog, examinons quelques modifications utiles que vous pouvez apporter à votre flux.

N’incluez pas le contenu complet de la publication dans votre flux RSS WordPress

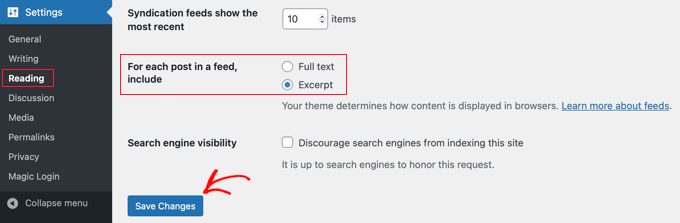

Vous pouvez inclure un résumé de chaque publication dans votre flux RSS au lieu du contenu intégral. Ce résumé comprend un extrait ainsi que les métadonnées de la publication telles que la date, l’auteur/autrice et la catégorie.

Dans la communauté des blogueurs, la question de savoir s’il est préférable d’avoir des flux RSS complets ou des flux résumés fait l’objet d’un débat. Nous n’entrerons pas dans ce débat maintenant, sauf pour dire que l’un des avantages d’un simple résumé est qu’il aide à prévenir le grattage de contenu.

Vous pouvez modifier les réglages en allant dans Réglages ” Lecture dans votre panneau d’administration WordPress. Vous devez sélectionner l’option ” Extrait “, puis cliquer sur le bouton ” Enregistrer les modifications “.

Désormais, le flux RSS affichera uniquement un extrait de votre article. Si quelqu’un vole votre contenu par le biais de votre flux RSS, il obtiendra uniquement le résumé, et non la publication complète.

Si vous souhaitez ajuster le résumé, alors vous pouvez consulter notre guide sur la façon de personnaliser les extraits WordPress.

Optimisez votre flux RSS pour éviter le scraping

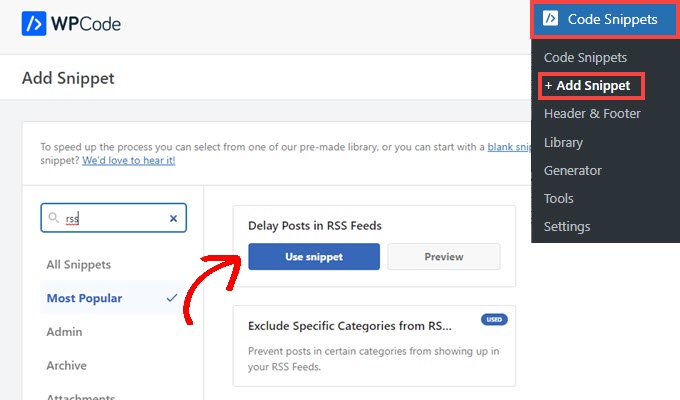

Il existe d’autres moyens d’optimiser votre flux RSS WordPress pour protéger votre contenu, obtenir plus de backlinks, augmenter votre trafic web, et plus encore. L’un des meilleurs moyens consiste à retarder l’apparition des publications dans le flux RSS.

L’avantage est que lorsque vous retardez l’apparition des publications dans votre flux RSS, vous donnez aux moteurs de recherche le temps d’explorer et d’indexer votre contenu avant qu’il n’apparaisse ailleurs, par exemple sur des sites d’exploration. Les moteurs de recherche considèrent alors que votre site fait autorité.

Le moyen le plus sûr et le plus facile de le faire est d’utiliser WPCode parce qu’il a une recette qui ajoute automatiquement le code personnalisé correct à WordPress.

Pour des instructions détaillées, consultez notre guide sur la façon de retarder l’apparition des publications dans votre flux RSS WordPress.

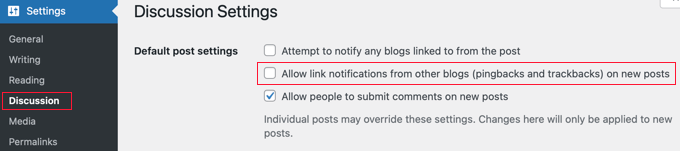

3. Désactiver les rétroliens, les pingbacks et l’API REST

Dans les premiers temps des blogs, les rétroliens et les pingbacks ont été introduits pour permettre aux blogs de s’informer mutuellement de l’existence de liens. Lorsque quelqu’un crée un lien vers une publication sur votre blog, son site envoie automatiquement un ping au vôtre.

Ce pingback apparaîtra alors dans la file d’attente de modération des commentaires de votre blog avec un lien vers leur site. Si vous l’approuvez, ils obtiendront un lien retour et une mention de votre site.

Cela incite le spammeur à pirater votre site et à envoyer des rétroliens. Heureusement, vous pouvez désactiver les rétroliens et les pingbacks pour donner aux spammeurs une raison de moins de voler votre contenu.

En savoir plus, consultez notre guide sur la désactivation des rétroliens sur toutes les futures publications. Vous aimerez peut-être aussi apprendre comment désactiver les rétroliens et les pings sur les publications WordPress existantes.

Désactiver l’API REST de WordPress

Outre les rétroliens et les pingbacks, nous vous recommandons également de désactiver l’API REST de WordPress, car elle peut permettre aux spammeurs de récupérer plus facilement votre contenu.

Nous avons un guide détaillé sur la façon dont vous pouvez désactiver l’API REST de WordPress.

Il vous suffit d’installer et d’activer l’extension WPCode gratuite et d’utiliser leur extrait prédéfini pour désactiver l’API REST.

4. Bloquer l’accès du scrapeur à votre site WordPress

L’un des moyens d’empêcher les scrapers de voler votre contenu consiste à leur interdire l’accès à votre site. Vous pouvez le faire manuellement en bloquant leur adresse IP, mais la plupart des utilisateurs/utilisatrices trouveront plus facile d’utiliser une extension de sécurité telle qu’un pare-feu d’application web.

Bloquer le scraper à l’aide d’une extension de sécurité (recommandé)

Le blocage manuel des “scrapers” est une opération délicate qui demande beaucoup de travail. D’autant plus que de nombreuses tentatives de piratage et d’attaques sont effectuées à l’aide d’une large plage d’adresses IP aléatoires provenant du monde entier. Il est presque impossible de suivre toutes ces adresses IP aléatoires.

C’est pourquoi vous avez besoin d’un pare-feu d’application Web (WAF) tel que Wordfence ou Securi. Ceux-ci agissent comme un bouclier entre votre site web et tout le trafic entrant en surveillant le trafic de votre site web et en bloquant les menaces de sécurité courantes avant qu’elles n’atteignent votre site WordPress.

Pour le site WPBeginner, nous utilisons Sucuri. C’est un service de sécurité de site web qui protège votre site contre de telles attaques à l’aide d’un pare-feu d’application de site web.

En principe, tout le trafic de votre site passe par les serveurs du service de sécurité, où il est activé pour détecter toute activité suspecte. Ils bloquent automatiquement les adresses IP suspectes afin qu’elles n’atteignent pas votre site. Découvrez comment Sucuri nous a aidés à bloquer 450 000 aides WordPress en 3 mois.

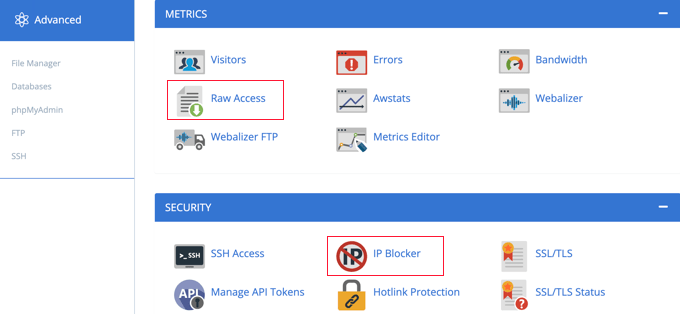

Bloquer ou rediriger manuellement l’adresse IP du scraper

Les utilisateurs/utilisatrices avancés peuvent également souhaiter bloquer manuellement l’adresse IP d’un scraper. Cela demande plus de travail, mais vous pouvez cibler spécifiquement l’adresse du scraper une fois que vous l’avez identifiée. Le développeur/développeur web Jeff Star suggère cette approche lorsqu’il explique comment il traite les scrappeurs de contenu.

Note : Il peut être dangereux d’ajouter du code aux fichiers d’un site. Même une petite erreur peut provoquer des erreurs majeures sur votre site. C’est pourquoi nous recommandons cette méthode uniquement aux utilisateurs/utilisatrices avancés.

Vous pouvez trouver l’adresse IP du scraper en consultant les “Journaux d’accès bruts” dans le tableau de bord cPanel de votre compte d’hébergeur. Vous devez rechercher les adresses IP dont le nombre de demandes est anormalement élevé et en garder une trace, par exemple en les copiant dans un fichier texte distinct.

Astuce : Vous devez vous assurer que vous ne vous bloquez pas, que les utilisateurs/utilisatrices légitimes ou les moteurs de recherche n’ont pas accès à votre site. Copiez une adresse IP suspecte et utilisez des outils de recherche d’adresses IP en ligne pour en trouver davantage.

Une fois que vous êtes certain que l’adresse IP appartient à un scraper, vous pouvez la bloquer à l’aide de l’outil “IP Blocker” du cPanel ou en ajoutant un code comme celui-ci dans votre fichier racine .htaccess:

1 | Deny from 123.456.789 |

Confirmez que vous remplacez l’adresse IP dans le code par celle que vous souhaitez bloquer. Vous pouvez bloquer plusieurs adresses IP en les saisissant sur la même ligne, séparées par des espaces.

Pour des instructions détaillées, consultez notre guide sur le blocage des adresses IP dans WordPress.

Au lieu de simplement bloquer les “scrapers”, Jeff suggère de leur envoyer des flux RSS factices. Vous pourriez créer des flux remplis de Lorem Ipsum et d’images gênantes ou même les renvoyer directement à leur propre site, ce qui provoquerait une boucle infinie et ferait planter leur serveur.

Pour les rediriger vers un flux factice, vous devrez ajouter un code comme celui-ci à votre fichier .htaccess :

1 2 | RewriteCond %{REMOTE_ADDR} 123\.456\.789\.RewriteRule .* http://dummyfeed.com/feed [R,L] |

5. Prévenir le vol d’images sur WordPress

Il n’y a pas que le contenu écrit que vous devez protéger. Vous devez également prévenir le vol d’images sur WordPress.

Comme pour le texte, il n’y a aucun moyen d’empêcher complètement les gens de voler vos images, mais il existe de nombreuses façons de décourager le vol d’images sur un site WordPress.

Par exemple, vous pouvez désactiver le hotlinking de vos images WordPress. Cela signifie que si quelqu’un scrape votre contenu HTML, ses images ne se chargeront pas sur son site.

Il réduira également la charge de votre serveur et l’utilisation de la bande passante, boostant ainsi la vitesse et les performances de WordPress.

Vous pouvez également ajouter un filigrane à vos images pour vous en attribuer la paternité. Cela montrera clairement que le scrapeur a volé votre contenu.

Vous pouvez apprendre ces deux techniques, ainsi que d’autres moyens de protéger vos images, dans notre guide sur les moyens de prévenir le vol d’images sur WordPress.

6. Décourager la copie manuelle de votre contenu

Si la plupart des scrapers utilisent des outils automatiques, certains voleurs de contenu peuvent essayer de copier manuellement tout ou partie de votre contenu.

L’un des moyens de rendre cela plus difficile est de les empêcher de copier et de coller votre texte. Pour ce faire, il est plus difficile pour eux de sélectionner le texte sur votre site.

Pour savoir comment empêcher la copie manuelle de votre contenu, consultez notre guide étape par étape sur la façon d’empêcher la sélection de texte et le copier/coller dans WordPress.

Cependant, cela ne protège pas complètement votre contenu. N’oubliez pas que les utilisateurs/utilisatrices avertis peuvent toujours voir le code source ou utiliser l’outil Inspect pour copier tout ce qu’ils veulent. En outre, cette méthode ne fonctionnera pas avec tous les navigateurs web.

N’oubliez pas non plus que toutes les personnes qui copient votre texte ne sont pas forcément des voleurs de contenu. Par exemple, certaines personnes peuvent vouloir copier le titre pour partager votre publication sur les réseaux sociaux.

C’est pourquoi nous vous recommandons d’utiliser cette méthode uniquement si vous estimez qu’elle est vraiment nécessaire pour votre site.

7. Tirer parti des racleurs de contenu

À mesure que votre blog prend de l’ampleur, il est presque impossible d’arrêter ou de suivre tous les racleurs de contenu. Nous envoyons toujours des plaintes DMCA. Cependant, nous savons qu’il y a des tonnes d’autres sites qui volent notre contenu et que nous n’arrivons pas à suivre.

Notre approche consiste plutôt à essayer de tirer profit des scrapeurs de contenu. Ce n’est pas si mal quand on voit que l’on gagne de l’argent grâce à son contenu volé ou que l’on reçoit beaucoup de trafic du site d’un scrapeur.

Prenez l’habitude de créer des liens internes pour gagner du trafic et des backlinks à partir de scraps.

Dans notre guide ultime sur le référencement, nous vous recommandons de faire du linking interne une habitude. En plaçant des liens vers vos autres contenus dans vos publications de blog, vous pouvez augmenter le nombre de pages vues et réduire le taux de rebond sur votre propre site.

Mais il y a un deuxième avantage au scraping. Les liens internes vous permettront d’obtenir de précieux backlinks de la part des personnes qui volent votre contenu. Les moteurs de recherche comme Google utilisent les backlinks comme signal de classement, donc les backlinks supplémentaires sont bons pour votre référencement.

Dernier point, ces liens internes vous permettent de voler l’audience du scraper. Les blogueurs talentueux placent des liens sur des mots-clés intéressants, ce qui incite les utilisateurs/utilisatrices à cliquer. Les internautes du site du scraper cliqueront également sur les liens, ce qui les fera directement prospecter vers votre propre site.

Auto Link Keywords With Affiliate Links to Make Money from Scrapers (liens automatiques vers des mots-clés avec des liens d’affiliation pour gagner de l’argent avec les scrapeurs)

Si vous gagnez de l’argent sur votre site grâce au marketing d’affiliation, nous vous recommandons d’activer les liens automatiques dans vos flux RSS. Cela vous aidera à maximiser vos revenus provenant des lecteurs qui lisent votre site uniquement via des lecteurs RSS.

Mieux encore, il vous aidera à gagner de l’argent grâce aux sites qui volent votre contenu.

Il suffit d’utiliser une extension WordPress comme ThirstyAffiliates qui remplacera automatiquement les mots-clés assignés par des liens d’affiliation. Nous vous affichons la marche à suivre dans notre guide sur la façon de lier automatiquement des mots-clés avec des liens d’affiliation dans WordPress.

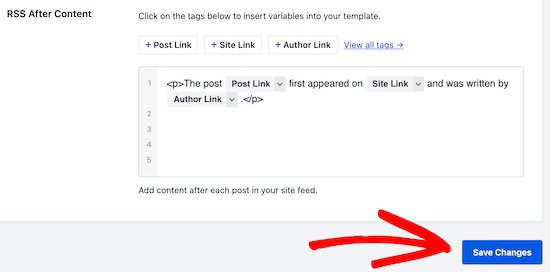

Faites la promotion de votre site dans votre pied de page RSS

Vous pouvez utiliser l’extension All in One SEO pour ajouter des articles personnalisés à votre pied de page RSS.

Par exemple, vous pouvez ajouter une bannière qui fait la promotion de vos propres produits, services ou contenus.

Le plus beau, c’est que ces bannières apparaîtront également sur le site du scraper.

Dans notre cas, nous ajoutons toujours un petit avertissement au bas des publications dans nos flux RSS. Ce faisant, nous obtenons un lien vers l’article original à partir du site du scrapeur.

Cela permet à Google et aux autres moteurs de recherche de savoir que nous sommes l’auteur/autrice. Cela permet également aux utilisateurs/utilisatrices de savoir que le site vole notre contenu.

Pour plus d’astuces, consultez notre guide sur le contrôle du pied de page de votre flux RSS dans WordPress.

Nous espérons que ce tutoriel vous a aidé à apprendre comment empêcher le scraping de contenu de blog sur WordPress. Vous pouvez également consulter notre guide ultime de sécurité WordPress ou notre choix d’experts des meilleures extensions de protection de contenu pour WordPress.

Si vous avez aimé cet article, veuillez alors vous abonner à notre chaîne YouTube pour obtenir des tutoriels vidéo sur WordPress. Vous pouvez également nous trouver sur Twitter et Facebook.

Moinuddin Waheed

I have many friends who used to talk to me about using RSS feed and make content on their website this way. I was not aware exactly how it worked and what benefits they incurred by doing that.

Scraping others content and showing as if they are themselves have created is an offense but in unethical world who cares. Thanks for making this guide by following which we can prevent our content from scraping and atleast can turn it to our advantage.

Jiří Vaněk

Thank you for the article. I have a blog with over 1200 articles, and I need to start addressing that as well. Thanks for the valuable advice.

WPBeginner Support

You’re welcome!

Admin

Toheeb Temitope

Thanks for the post.

But can I even remove the or disable RSS feed totally or is there any special benefit in it.

Then if I want to disable RSS feed totally, how will I do it.

Thanks.

WPBeginner Support

If you want to disable the RSS feed for your site, our guide below would be helpful:

https://www.wpbeginner.com/wp-tutorials/how-to-disable-rss-feeds-in-wordpress/

RSS feeds can be helpful to certain users of your site who use RSS feed readers to know when a site has new content.

Admin

Moinuddin Waheed

it is good idea to know that we can even disable the RSS feed thus by preventing the potential theft and scraping of the content.

though disabling the RSS feed has some trade off as well.

is there any seo disadvantage of disabling the RSS feed?

or it has nothing to do with seo and ranking ?

WPBeginner Support

Your RSS feed should not affect your site’s SEO.

Giovanni

Thank you. Exactly the information I need. But do scrapers use RSS feed still in 2019?

WPBeginner Support

They certainly can and will try to

Admin

Nergis

We hear so much about getting site content by doing content curation. Is content scrapping the same as content curation? If not what’s the difference between the two?

WPBeginner Support

Content scraping is taking content from other sites to place on your site without permission, content curation is normally linking to other content within content you have created

Admin

Kingsley Felix

I am facing these issues, i had 20+ for one of our brands, then we moved elsewhere and they are back again.

WPBeginner Support

content scrapers are a constant strugle sadly

Admin

slevin smith

I found a realy bad content scaper from by blog, not only they steal my content, used the same name for they spam blog only separatedwith a – and all description, tag, basicly trying to be me, is used links in rssfeed with my blog, youtube channel, facebook, twitter, pinterest & google plus, which shows up on there spam blog, also found that png images shows up on the front page but jpeg dose not, but that maybe just on blogger.

astrid maria boshuisen

I absolutely love the interlinking-idea. Will have to look at the RSS suggestion, since I forgot how that works exactly, having focussed on writing Kindle e-books for a while (talk about content scraping – zero protection there!.. hence my return to website writing) but I feel I have really got a place to start with protecting my content! Thanks!

Danni Phillips

WOW! So much to take into consideration when starting a blog. My blog is only 2 weeks old. I have used mainly WP Beginner to set up my blog. So much good info set out in a way a newbie can follow.

I don’t know if this works for content scraping but I have installed a plugin called Copyright Proof. It disables right click so that people can not copy and paste your content.

I decided to use this plugin as it was a recommended plugin for author sites.

Eri

your post can be copied easy , trust me.

Reo

Disabling selection is good method but it only support famous web browser like Chrome, Safari and Opera but not IE and Edge.

Dave Coldwell

Another great article, I work as a freelance journalist so I sell a lot of articles and it’s up to the people who buy it to decide on their policies.

But I also have a couple of blogs and affiliate websites so I think I might need to take a look at what’s happening with my content.

Absynth

Does not giving credit where it’s due count as “content scraping”?

Because Jeff Starr wrote this same post at Perishable Press over 5 years ago:

Check the structure and terminology of your article and compare it to the original.

Just sayin.

WPBeginner Support

We did give credit to Jeff Starr. Please read the actual article before pointing out errors.

Admin

Absynth

Yes my apologies.. I missed that the first time through. My bad

Sieu

i has just develop a theme for blogger and that theme need a full feed to work, i worry about scrapping content, i think if many scrapper use my content on their blogger site, which have the same content with my site, backlink point to mysite, my blog will be spam in Google ‘s eye and will be deleted.

Lori

Thanks for this amazing article with useful tips! I actually just got a “Thin Content” penalty from Google. I asked an SEO expert for help, they told me to stop scraping content. They sent me a link of an article I wrote yesterday and thought I had stolen it from another website. The crappy thing is, they were stealing from me, not just that article, but probably a couple thousand articles! They are still in Google search, and I am not. I am being the one penalized! Turns out there are at least three websites scraping my content, not even sure what to do.

Raviraj

Awesome article.

I sort of agree with most of the points you have discussed. Actually few of the points are pretty awesome.

But if your sole business is based on content in your website, shouldn’t we be more careful about scrapers?

I don’t think content theft would ever be good to the owner of the content.

I guess we all should think of opting some preventive measure rather than reactive measure. You can consider using ShieldSquare, a content protection solution to stop content scraping permanently.

Andre

I know this is an old article, but the one source that is NOTORIOUS for allowing content scaping is WordPress with their “Press This” feature. They are basically encouraging this.

Sara

I think I may have finally found the answer to my problem. I have been thinking someone has been stealing my stories and making them into “new” stories. I thought either someone is out to get me or I am losing my mind. I was almost losing my mind over thinking like this. Paranoid. Concerned someone was listening to my private phone calls. When really, all the information has come directly from my blog! This article may have saved my life. Literally. I am not even joking because I have been so afraid that I was going crazy and very selectively trying to talk about it with friends, to get feedback or support and being looked at like I am nuts and need to go to the psych ward for a while. This article makes what has been happening to me, make total sense. Thank you! I am so overwhelmed with relief.

John

Thanks for some tips but a good chunk of this article is not very helpful. Most scrappers are not blind scrappers, the content is generally sucked, looked at by a human eye and then published. Which means that even by taking a minute to look at an article the spam kid is able to publish hundred of copied article a day. Backlinks problem is very easy to circumvent for content scrapper as the feed importers have pre-process options and they generally set it to delink the body. Also I do not see how turning rss into summary may help at all, the feed importers only use the rss to grab the new content link and from there they follow the skeleton of your html, which you have nicely set with proper image, title, link etc tags for the convenience of Google and very easily extract the content.

Obviously blocking the IP is a very good solution. DMCAs are generally a waste of time; they take time to formulate and stupid hosts take time to respond (since spammers choose these host specifically because they’re lax on spam-like activity). Of all, Google is the most frustrating; no matter how many reports you file with them they never take action on any of the stolen content on which they’re showing ads and still rank the crap-spam site well on the search results despite it being easy for their systems to detect copies

Evie

John, I couldn’t agree with you more. Google got mad at me stating that I was the person stealing my own content. This person stole my content and put it on blogger. The nerve. There needs to be a solution for this. At this point, I just block!

WPBeginner Staff

Then perhaps the best way for you is to change the licensing and aggressively send take down notices to content scrappers. Meanwhile keep focusing on creating quality content.

Philipp D

Hi there,

I just stumbled upon your article while looking for answers to some of my concerns.

I, together with some friends, launched a website about DIY in Italy, few months ago, which is working unexpectedly well, rankings are high, lots of traffic, etc. Still, PR is yet 0. Our content has a Creative Commons 4.0 license, because we realyl believe it’s a good way to share contents. HOWEVER:

Some time ago we noticed a PR4 site with lots of traffic copying our top articles, linking back to our homepage (which is not what you’re supposed to do with a CC license, but it’s still ok). The problems are these:

1. there’s a whole lot of smaller sites scraping their (our) content and linking back to them instead of our site

2. the PR4 site and some of the smaller sites somehow rank better than our site

3. there’s strong suggestions that a Google penalty to OUR content has taken place, as it has lower PR than most of the other pages (which have been online for a long time).

We’re in contact with the PR4 site and it’s ok for us if they use our content, as long as they link back to the original article (that’s the whole point of the CC license), BUT we’re trying to find a solution to avoid getting Google penalties: would rel canonical do the job? What is your opinion? Whould we change our license and be more aggressive towards content copying?

Thank you!

WPBeginner Support

Philipp, If you have not already done so, then you should create a webmaster tools account for your site and submit your sitemap. It helps you figure out if there is a problem with your site, how your site is doing on search, and you can use lots of other tools. It also helps Google better understand where some content first appeared.

We don’t think changing the license will stop content scrappers from copying your content.

Admin

Philipp

hi! Yes, we set up a webmaster tools account, linked the site to our google+ page, and most of the authors to their google+ profiles using publisher and author tags. authorship seems to be working fine in search snippets, but so far it doesn’t seem to make much difference in case of scraped content. Higher PR pages scraping our content are still on top…

Garratt

One of the best ways not to be effected by this is to ping effectively. Pinging, and manually submitting pages to Google and Bing gets spiders on your site FAST. They index the pages ASAP, then when they find duplicate content on other sites consider you as the authority.

I do however have the sneaky suspicion this might have to do with PageRank though… But Matt Cutts (webspam team @ Google) has advocated using pinger’s on this very topic. I’m just not sure how much I can trust what he says though.

To add more services, go to Settings -> Writing Settings -> Update Services -> Open the “Update services” link in a new tab and copy all the update services. Back in WordPress paste them in the ping list and click save.

Open account in Bing Webmaster tools for manual URL submission for fast indexing.

Chris Backe

I recently discovered a guy that can taking an RSS feed from my blog – bear in mind that my blog is a summary feed with Yoast’s ‘This post was found first on’ line. I sent the guy a thank-you message, basically telling him that he’s giving me backlinks, AND telling Google he’s copying my website (since they can look at the timestamps to see which was published first).

Checked out 2 days later, and all my stuff was mysteriously gone…

Editorial Staff

Hah yup. Most of these scammers aren’t very bright lol. Glad you got it fixed.

-Syed

Admin

Ian

Has anyone seen or used this WP anti scraping plugin http://wordpress.org/plugins/wordpress-data-guards/ it sounds solid but very few people have downloaded it ? I’m not technical – so would appreciate opinions on its worth or effect on SEO

Editorial Staff

You can definitely use that plugin. It blocks right clicks, keyboard shortcuts for copying, ip blacklist etc. Those all prevent manual scraping however most content scrapers use automatic tools. So none of those would be super helpful.

Admin

Ian

Thanks for your reply – the pro version states it protects you from bot attacks so I assume that means scrapper bots? the price puts me off installing it on all my sites, but I may use it on one just to see how well it works

Mark Conger

This is one of, if not the best, “beginner” article I’ve ever come across on the web.

After reading it I feel like I just had a meeting with a security consultant.

I’m applying these techniques right frickin now!

Thanks. I’m now a follower of this site.

Editorial Staff

Thanks for the very kind words Mark

Admin

Neil Ferree

Its only happened to me a few times. Some blogger from outside the USA has taken my post word-for-word and posted to their site as if it were their own. Since it was just a single post with my YT video embedded, I didn’t sweat the details too much, since my channel CTR saw a nice spike it visits anyway.

Edward B. Rockower, Ph.D.

Just want to say thanks, thanks, and thanks!

I just today discovered your website, only read 3 articles so far (including this one)… but I’m extremely impressed.

I’ve only been blogging now for 5 weeks, but finding it addictive, especially seeing the growing traffic and user engagement as a result of my efforts. Seeing 100 visitors to my blog site in one day, and being able to see who’s referring them, motivates me to learn all I can to increase the social media marketing and interactions with new visitors.

Best regards,

@earthlingEd

Debbie Gilbert

I love your Website and was floored to read about content scraping! Is there and way to create a watermark somehow which is not distracting to your readers but to the scraper’s site is dead obvious?

Editorial Staff

You can do hotlink protection among other things to disable images on domains that are not whitelisted.

Admin

Usman

Is it legal to post the complete article from another website and writing source website name at bottom of article?

Editorial Staff

No.

Admin

Usman

And if we give direct link to article at bottom?

Dan

It is still not good unless the owner approves it

Abdul Karim

Is there any way / plugin

someone is copy my fashion blog picture and post it at their forum

but when i click on image at that forum . its open in new window

i want any plugin or script that if he copy my images when someone click on that images, then that person redirect to my blog post related to that images ?

any plugin yet ? link with post images ?

Editorial Staff

None that we know of.

Admin

Abdul Karim

I’ll done it just change

when someone upload any picture on right side it shows url link

default setting is media file

u have to change it in attachment url

then done!

when someone copy your blog images .that give backlink to your posted page

Anton

If someone takes an article written in English and translate it, using their heads and not google translate, into some other language, lets say because the majority of the people in the country of that other language doesn’t understand English. Would you point them out as scrapers anyway? Or what is your opinion on that?

For me personally I don’t find it extremely problematic, of course I believe the “author” should link bank to the original article while clarifying that his article is translated.

Editorial Staff

Unless you have written permission of the author, then it is technically scraping.

Admin

Greg

This is a tremendous article. After reading it I hope you do not see me as a content scraper. I have used excepts from you (curated), I always have the ‘Read the Full Article” and have your page link there and also many of my posts are tweeted and I include your twitter account in there. If you do not want this please let me know and I will gladly remove it. I am very appreciative of your work and want to share it with my visitors. it is not intended to steal your visitors but to be able to give good value to mine and send them on to you for more.

Editorial Staff

Greg, as long as you only display an excerpt and send the user over to our site to read the full article, then it is not scraping. As you said, it is curation. Tons of popular sites do that (i.e reddit, digg, etc).

Admin

ryan

My site has a lot of original security articles and a couple have been scraped. The site that scraped me was in yahoo! News with my article and had people commenting on it. I dealt with the issue by commenting and saying I was the original author and replied to a few comments. I had internal links, that’s how I found out so quickly. A trick I am going to write about is getting people who come from a scrapers site and have a banner or image appear telling them what happened. The never ending request suggestion sounds illegal under the computer fraud and abuse act. I am not a lawyer. I just write about security, so I have to know the security laws for computers.

I Do not like it that your form didn’t take my companies email as a valid email.

Editorial Staff

Sorry Ryan that our form didn’t approve your business email. Not sure what happened there, but it is meant to approve all valid emails.

Admin

andre

how to use this code, can you provide more details or tutorials, thank you

RewriteCond %{REMOTE_ADDR} 123\.456\.789\.

RewriteRule .* http://dummyfeed.com/feed [R,L]

Editorial Staff

You would have to edit the .htaccess file.

Admin

Ali Rashid

nice and informative writeup i like your approach of taking advantage of the scrappers however blocking an ip may not always work; a serious scrapper would often use a list of anonymous or free proxies in that case blacklisting one ip might not be an effective solution as the scrapper would change it often. One solution is to write a small script that will detect any abnormal traffic from a given ip, say more than 20 hits/sec and challenge it with a captcha if no reply, put the ip in a temp blacklist for about 30 mins. you can hardened it with another javascript that detects mouse, touch or keyboard movement after few hits, if no keyboard, mouse, or touch is detected you can again put the scrapper in the temp blacklist, worked like a charm for us.

Arihant

Your solutions are good enough for content scrapers.

But what if people are manually coping and pasting content into their Facebook pages.

We have implemented tynt but they remove the link back to original article, any ideas on how you can handle this kind of situation.

Editorial Staff

If people really want to steal your content, there is nothing you can do about it. It’s a sad truth, but it’s a truth.

Admin

Garratt

Actually there’s a plugin created by IMWealth Builders, probably the only one of their plugins I like, the rest are pretty trashy and involve scraping Ecommerce sites (CB,Azon,CJ etc) for affiliate commisions.

It’s called “Covert Copy Traffic” is actually allows you to set any text pre or post a set number of words. So say I set it to post “This content was taken from xxxxxxx.com” after 18 words. Then anytime someone copied/paste more than 18 words from the website it would add that text at the bottom, 17 words or less it would do nothing.

These were just example settings. Pretty useful plugin, works a charm. I’ve tried just about every way I could think of to bypass the text insertion but it seems to be impossible. Plugin is to stronk.

Editorial Staff

Sounds like you are describing this tutorial here:

https://www.wpbeginner.com/wp-tutorials/how-to-add-a-read-more-link-to-copied-text-in-wordpress/

Garratt

Yeah, that’s right. You can just use that script to say “Content came from yourwebsite.com” rather than “Read More”.

Jennae Barker

Is this true that their amazon etc programs are scrapers – if that is the case – I have made whopper of mistake on a purchase from them – luckily, I have not used it yet.

Garratt

Yeah Jennae, it’s legal in terms of Amazon allow you to copy content from their pages. It helps there sales, affiliates are the reason Amazon is Amazon.

However Google and other search engines (that matter) just consider it a “thin affiliate site” as in no original content. Therefore they don’t rank unless there’s a certain percentage of original content on the site as well.

A scraper, is nothing more than a spider/crawler generally it runs in socket mode, however some run in browser.

Just because it’s labeled as a scraper doesn’t make it bad per say, I use scrapers and spiders regularly to check my site for unnatural links, I check others for competition analysis, and keyword research and a variety of other tasks that do not harm anyone, but benefit me.

However I don’t like or condone anyone scraping for the purpose of copyright infringement. Which is what this discussion is really about.

Google uses the spider “Google Bot” to index the web along with 100’s of other search engines, there’s thousands, hundreds of thousands of spiders crawling the web for a variety of purposes. Google also scrapes websites to “cache” them. As do a lot of important services we need such as the historical web archives.

Troy

I’m about to begin aggressively searching for sites that are copying my content and have the content removed. I no it is impacting how my site ranks so I have to do something about it. Any idea how much has to be copied before you can deliver DMCA notices? Is a paragraph in an article enough to legally be able to call it plagiarized?

Editorial Staff

We are not legal experts here, so we refrain from giving legal advice on this site.

Admin

Dallas

You fail to mention that any self respecting autoblogger will strip out links and insert their own affiliate links rather than using your content as it comes, so your approach to getting links from them will usually fail.

Editorial Staff

Is there such thing as a self respecting autoblogger? If they have any self respect, then they will write original content.

Admin

David Halver

Agreed! There’s a very special “Hot Place” near the center of the Earth for Spammers, Scrapers and Auto-Bloggers…

VeryCreative

I think that the best idea is to include affiliate links.

After the last Pinguin update, my website was penalized. I started to analyze it and I’ve discovered that many other sites copied my content. I don’t know why, but those websites rank better than me in search engines, using my content.

Editorial Staff

Not just affiliate links. Include as many internal links. Because if those sites are linking back to your other pages, then Google will KNOW that you are the authority site.

Admin

Bayer

Hi wpbeginner.com Team. I really appreciate this article, but have one question in regards to having internal links in your pages/posts.

I suppose you mean ‘absolute’ links?? Otherwise this may not work in your favour, once the content has been scraped… Well, so far I have always been going along with relative links, as you do I suppose. Which is the best method? Cheers!

Editorial Staff

We always use absolute links because it keeps thing working smooth.

Gautam Doddamani

first of all your tutorial is just fantastic..hats off! just one doubt how to know if a site is a scraper site? i used your method and found out that Google Webmaster Tools is reporting that there are 262 links to my site and there are many sites which dont know of…thus i am in a confusion….how to check if a site is a scraper site or an authoritative site?? is der a tool available for that? thanks in advance!

Editorial Staff

Trust me, no authority site will ever STEAL your article word-for-word.

Admin

Gautam Doddamani

yes that is true…but what if i dont want to find my article on those scraping sites…i know my article is there as it is being reported by GWT and i just want to block that IP address by inserting those rewritecond rules in the htaccess file…i dont want to waste my time searching those bad sites for my article or requesting them to takedown my article…

Nathan

Thank you for this article – and for your site in general!. I like this so much that I had wondered how I would keep track of this resource. And now I see the subscriptions options below. What a way to get a comment!

Yeasin

Preventing content scraping is almost impossible. I don’t think content scrapper does hurt me any way. They are just voting me that i have got some high quality contents. Google is smart enough to detect the original publishers. No-one should worry.

mrwindowsx

really informative, if you use cloudflare, there is new apps called ScrapeShield, and you can easily protect and track/monitor your site contents free.

wpbeginner

@mrwindowsx Oh didn’t know that. Thanks for pointing it out.

Gautam Doddamani

wow dats great man…do you use cloudflare? i just wanted your review because i have never used that cdn service..i know it is free and all but i think my site load time is already gr8 that i didnt require it…now that scrapeshield is there i think i will definitely check it out…what all other apps will we get if we start using cloudflare?? thanks

Matt

Hello,

IMO @cloudflare really is awesome. I have two sites on it (both mine and my wife’s blog) and it really is incredibly fast, but that’s not to mention all of the security, traffic analysis, app support (automatic app installs) that they provide.

I know that all hosting setups are different, but I have both of our sites running on the Media Temple (gs)Grid Service. I can honestly say that our sites run faster now than they did when I was using W3 Total Cache and Amazon S3 as my CDN. Actually, I still use W3TC on my site to minimize & cache my content, but I use CloudFlare for CDN, DNS, and security services.

Highly recommend… Actually, I would really appreciate it if someone at WPBeginner would give us their in-depth, experienced opinion of the CloudFlare services. To me, they have been awesome!

shivabeach

You can also get a plugin whose name eludes me at this time that does the google search for you. It also adds a code into your RSS that the app searches for

MuhammadWaqas

Great post, I know there are many autoblogs fetching my content. Although after penguin update my site is getting 3 times more traffic from google than before. But after reading about many disasters or original content generators I’m worried about future penalties by google.

Its my experience that usually google respect high PR sites with good authority backlinks. but site is just one year old and PR is less than 5.

I try to contact scrappers but most of them don’t have contact forms. so I think I’ll try that htaccess method to blog the scrappers ip addresses. But only the other hand some of them can use feedburner.

Garratt

Personally I don’t bother with RSS as most users don’t use it. Instead supply a newsletter feed. It does the same trick + you get emails to market to (if done correctly). Majority of people are more likely to subscribe to a blog rather than bookmark a RSS in my experience. So it’s better to turn off RSS. You can do this using WordPress SEO by Yoast, and various other plugins.

Then if you also implement above mentioned strategies, you should be good. Remove all unnecessary headers RSD WLM etc.

There will be a couple still able to scrape effectively but those tricks will diminish a great deal of them.