Hier bei WPBeginner haben wir Millionen von Nutzern beraten, wie sie ihre Websites für die Suche optimieren und ihren organischen Traffic erhöhen können. Wir haben festgestellt, dass ein Aspekt der Suchmaschinenoptimierung, der von Anfängern oft übersehen wird, die robots.txt-Datei ist, die Suchmaschinen hilft, Ihre Website zu entdecken, zu crawlen und zu indizieren.

Diese einfache Textdatei dient als Anleitung, die den Suchmaschinen-Bots sagt, auf welche Teile Ihrer Website sie zugreifen sollen und welche sie in Ruhe lassen sollen.

Durch die Optimierung Ihrer robots.txt-Datei können Sie sicherstellen, dass Suchmaschinen sich auf das Crawling und die Indizierung Ihrer wichtigsten Inhalte konzentrieren und verhindern, dass sie Ressourcen für weniger wichtige Bereiche Ihrer Website verschwenden.

In diesem Artikel finden Sie einige Tipps, wie Sie eine perfekt optimierte robots.txt-Datei für Ihre WordPress-Website erstellen und so Ihr SEO-Potenzial maximieren können.

Was ist eine Robots.txt-Datei?

Robots.txt ist eine Textdatei, die Website-Besitzer erstellen können, um Suchmaschinen-Bots mitzuteilen, wie sie die Seiten ihrer Website crawlen und indizieren sollen.

Sie wird normalerweise im Stammverzeichnis (auch als Hauptordner bezeichnet) Ihrer Website gespeichert. Das grundlegende Format für eine robots.txt-Datei sieht wie folgt aus:

1 2 3 4 5 6 7 | User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap] |

Sie können mehrere Zeilen mit Anweisungen haben, um bestimmte URLs zuzulassen oder zu verbieten, und mehrere Sitemaps hinzufügen. Wenn Sie eine URL nicht verbieten, gehen die Suchmaschinenbots davon aus, dass sie sie crawlen dürfen.

So kann eine robots.txt-Beispieldatei aussehen:

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml |

Im obigen robots.txt-Beispiel haben wir Suchmaschinen erlaubt, Dateien in unserem WordPress-Uploads-Ordner zu crawlen und zu indizieren.

Danach haben wir Suchbots daran gehindert, Plugins und WordPress-Administrationsordner zu crawlen und zu indizieren.

Zum Schluss haben wir die URL unserer XML-Sitemap angegeben.

Brauchen Sie eine Robots.txt-Datei für Ihre WordPress-Website?

Wenn Sie keine robots.txt-Datei haben, werden Suchmaschinen Ihre Website trotzdem durchsuchen und indexieren. Sie können ihnen jedoch nicht mitteilen, welche Seiten oder Ordner nicht gecrawlt werden sollen.

Wenn Sie einen Blog zum ersten Mal starten und noch nicht viele Inhalte haben, wird dies keine großen Auswirkungen haben.

Wenn Ihre Website jedoch wächst und Sie mehr Inhalte hinzufügen, werden Sie wahrscheinlich eine bessere Kontrolle darüber wünschen, wie Ihre Website gecrawlt und indiziert wird.

Hier ist der Grund dafür.

Suchroboter haben eine Crawl-Quote für jede Website.

Das bedeutet, dass sie während einer Crawl-Sitzung eine bestimmte Anzahl von Seiten crawlen. Wenn sie ihr Crawl-Budget aufbrauchen, bevor sie alle Seiten Ihrer Website gecrawlt haben, kommen sie zurück und setzen das Crawlen in der nächsten Sitzung fort.

Dies kann die Indizierungsrate Ihrer Website verlangsamen.

Sie können dies beheben, indem Sie Suchbots daran hindern, unnötige Seiten wie Ihre WordPress-Verwaltungsseiten, Plugin-Dateien und Themes-Ordner zu crawlen.

Indem Sie unnötige Seiten nicht zulassen, sparen Sie Ihre Crawl-Quote. Dies hilft den Suchmaschinen, noch mehr Seiten auf Ihrer Website zu crawlen und sie so schnell wie möglich zu indizieren.

Ein weiterer guter Grund, eine robots.txt-Datei zu verwenden, ist, wenn Sie Suchmaschinen daran hindern wollen, einen Beitrag oder eine Seite auf Ihrer Website zu indizieren.

Dies ist zwar nicht die sicherste Methode, um Inhalte vor der Öffentlichkeit zu verbergen, aber sie hilft Ihnen zu verhindern, dass Inhalte in den Suchergebnissen erscheinen.

Wie sieht eine ideale Robots.txt-Datei aus?

Viele beliebte Blogs verwenden eine sehr einfache robots.txt-Datei. Ihr Inhalt kann je nach den Bedürfnissen der jeweiligen Website variieren:

1 2 3 4 5 | User-agent: *Disallow:Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

Diese robots.txt-Datei ermöglicht es allen Bots, alle Inhalte zu indizieren, und bietet ihnen einen Link zu den XML-Sitemaps der Website.

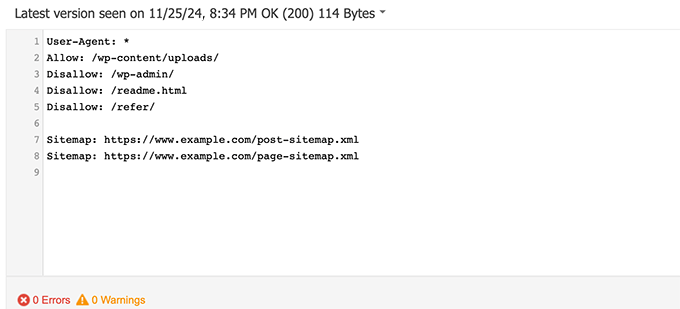

Für WordPress-Sites empfehlen wir die folgenden Regeln in der robots.txt-Datei:

1 2 3 4 5 6 7 8 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: https://www.example.com/post-sitemap.xmlSitemap: https://www.example.com/page-sitemap.xml |

Dies weist Suchbots an, alle WordPress-Bilder und -Dateien zu indizieren. Es verhindert, dass Suchbots den WordPress-Adminbereich, die Readme-Datei und getarnte Affiliate-Links indizieren.

Durch das Hinzufügen von Sitemaps zur robots.txt-Datei machen Sie es den Google-Bots leicht, alle Seiten Ihrer Website zu finden.

Da Sie nun wissen, wie eine ideale robots.txt-Datei aussieht, sehen wir uns an, wie Sie eine robots.txt-Datei in WordPress erstellen können.

Wie man eine Robots.txt-Datei in WordPress erstellt

Es gibt zwei Möglichkeiten, eine robots.txt-Datei in WordPress zu erstellen. Sie können die Methode wählen, die für Sie am besten geeignet ist.

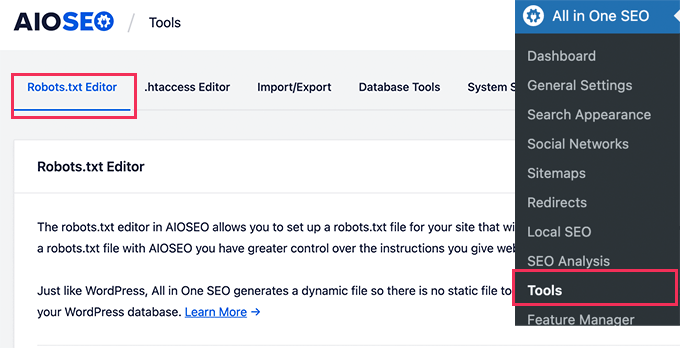

Methode 1: Bearbeiten der Robots.txt-Datei mit All in One SEO

All in One SEO, auch bekannt als AIOSEO, ist das beste WordPress-SEO-Plugin auf dem Markt und wird von über 3 Millionen Websites genutzt. Es ist einfach zu bedienen und kommt mit einem robots.txt-Datei-Generator.

Weitere Informationen finden Sie in unserem ausführlichen AIOSEO-Test.

Wenn Sie das AIOSEO-Plugin noch nicht installiert haben, können Sie sich unsere Schritt-für-Schritt-Anleitung zur Installation eines WordPress-Plugins ansehen.

Hinweis: Es gibt auch eine kostenlose Version von AIOSEO, die über diese Funktion verfügt.

Sobald das Plugin installiert und aktiviert ist, können Sie damit Ihre robots.txt-Datei direkt in Ihrem WordPress-Adminbereich erstellen und bearbeiten.

Gehen Sie einfach auf All in One SEO ” Tools, um Ihre robots.txt-Datei zu bearbeiten.

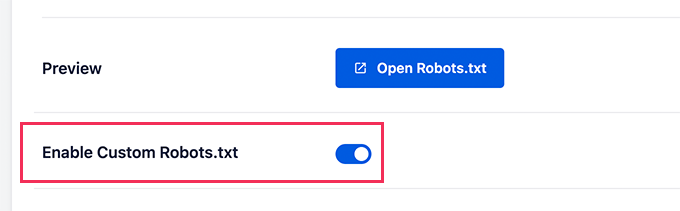

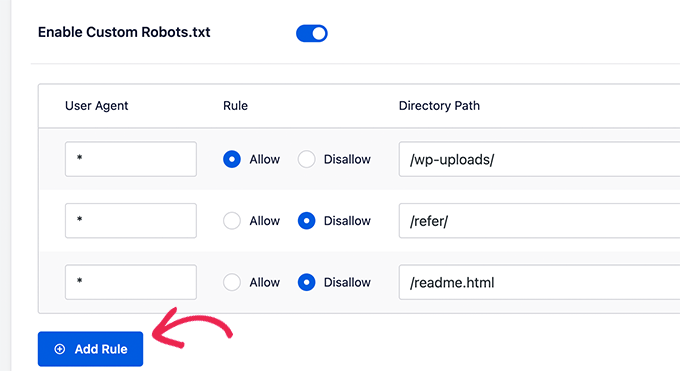

Zunächst müssen Sie die Bearbeitungsoption aktivieren, indem Sie den Schalter “Enable Custom Robots.txt” auf blau setzen.

Wenn Sie diese Option aktivieren, können Sie eine benutzerdefinierte robots.txt-Datei in WordPress erstellen.

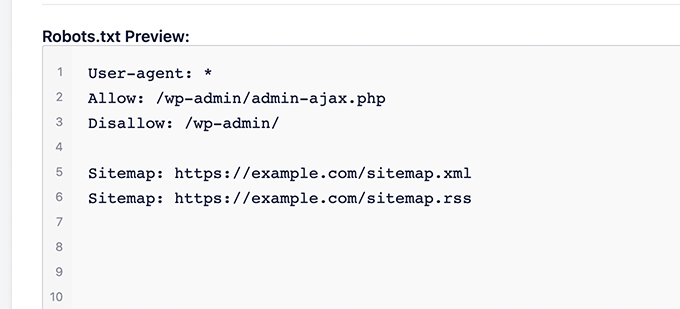

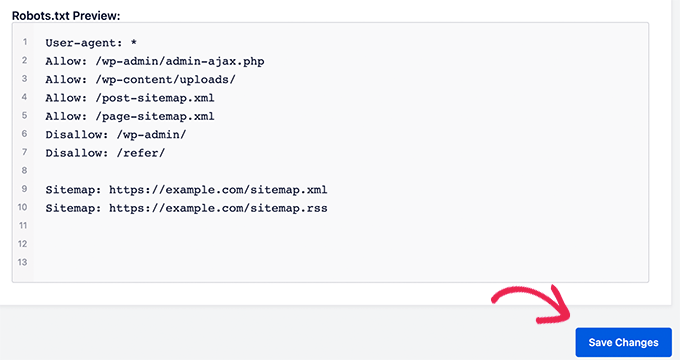

All in One SEO zeigt Ihre vorhandene robots.txt-Datei im Abschnitt “Robots.txt-Vorschau” unten auf dem Bildschirm an.

Diese Version zeigt die Standardregeln, die von WordPress hinzugefügt wurden.

Diese Standardregeln weisen die Suchmaschinen an, Ihre WordPress-Kerndateien nicht zu crawlen, erlauben den Bots, alle Inhalte zu indizieren, und bieten ihnen einen Link zu den XML-Sitemaps Ihrer Website.

Jetzt können Sie Ihre eigenen benutzerdefinierten Regeln hinzufügen, um Ihre robots.txt für SEO zu verbessern.

Um eine Regel hinzuzufügen, geben Sie einen User Agent in das Feld “User Agent” ein. Wenn Sie ein * verwenden, gilt die Regel für alle Benutzer-Agenten.

Wählen Sie dann aus, ob Sie das Crawlen durch Suchmaschinen zulassen oder verbieten wollen.

Geben Sie dann den Dateinamen oder den Verzeichnispfad in das Feld “Verzeichnispfad” ein.

Die Regel wird automatisch auf Ihre robots.txt angewendet. Um eine weitere Regel hinzuzufügen, klicken Sie einfach auf die Schaltfläche “Regel hinzufügen”.

Wir empfehlen, Regeln hinzuzufügen, bis Sie das ideale robots.txt-Format erstellt haben, das wir oben beschrieben haben.

Ihre benutzerdefinierten Regeln sehen dann so aus.

Wenn Sie fertig sind, vergessen Sie nicht, auf die Schaltfläche “Änderungen speichern” zu klicken, um Ihre Änderungen zu speichern.

Methode 2: Bearbeiten der Datei Robots.txt mit WPCode

WPCode ist ein leistungsfähiges Plugin für Codeschnipsel, mit dem Sie Ihrer Website einfach und sicher eigenen Code hinzufügen können.

Es enthält auch eine praktische Funktion, mit der Sie die robots.txt-Datei schnell bearbeiten können.

Hinweis: Es gibt auch ein kostenloses WPCode-Plugin, das jedoch nicht die Funktion des Dateieditors enthält.

Als Erstes müssen Sie das WPCode-Plugin installieren. Eine Schritt-für-Schritt-Anleitung finden Sie in unserem Leitfaden für Einsteiger zur Installation eines WordPress-Plugins.

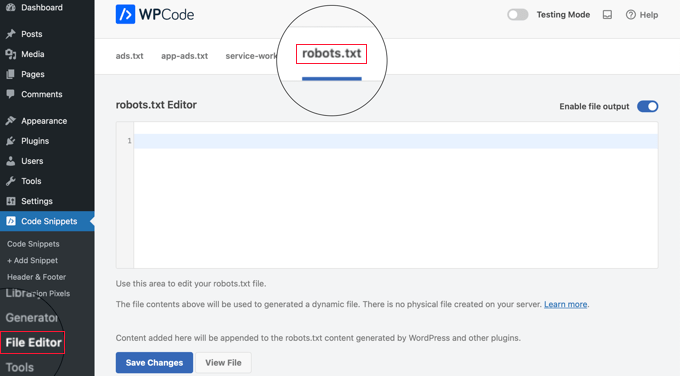

Nach der Aktivierung müssen Sie zur Seite WPCode ” File Editor navigieren. Klicken Sie dort einfach auf die Registerkarte “robots.txt”, um die Datei zu bearbeiten.

Nun können Sie den Inhalt der robots.txt-Datei einfügen oder eingeben.

Wenn Sie fertig sind, klicken Sie auf die Schaltfläche “Änderungen speichern” unten auf der Seite, um die Einstellungen zu speichern.

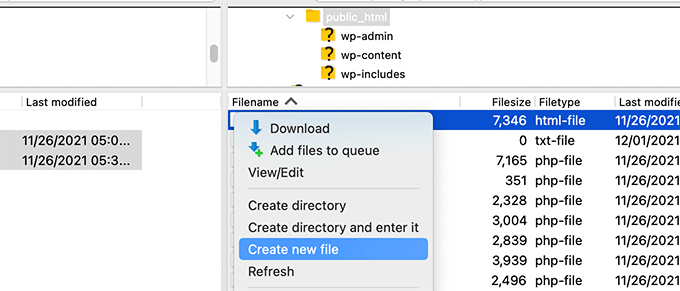

Methode 3: Manuelles Bearbeiten der Datei Robots.txt mit FTP

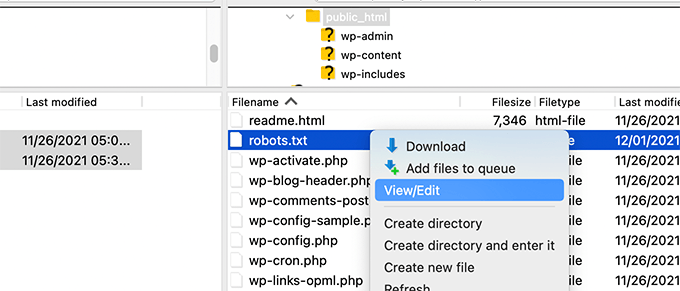

Für diese Methode müssen Sie einen FTP-Client verwenden, um die robots.txt-Datei zu bearbeiten. Alternativ können Sie den von Ihrem WordPress-Hosting bereitgestellten Dateimanager verwenden.

Verbinden Sie sich einfach über einen FTP-Client mit den Dateien Ihrer WordPress-Website.

Dort können Sie die Datei robots.txt im Stammverzeichnis Ihrer Website sehen.

Wenn Sie keine sehen, dann haben Sie wahrscheinlich keine robots.txt-Datei.

In diesem Fall können Sie einfach eine erstellen.

Robots.txt ist eine reine Textdatei, d. h. Sie können sie auf Ihren Computer herunterladen und mit einem beliebigen Texteditor wie Notepad oder TextEdit bearbeiten.

Nachdem Sie Ihre Änderungen gespeichert haben, können Sie die Datei robots.txt wieder in das Stammverzeichnis Ihrer Website hochladen.

Wie Sie Ihre Robots.txt-Datei testen

Sobald Sie Ihre robots.txt-Datei erstellt haben, sollten Sie sie mit einem robots.txt-Testprogramm überprüfen.

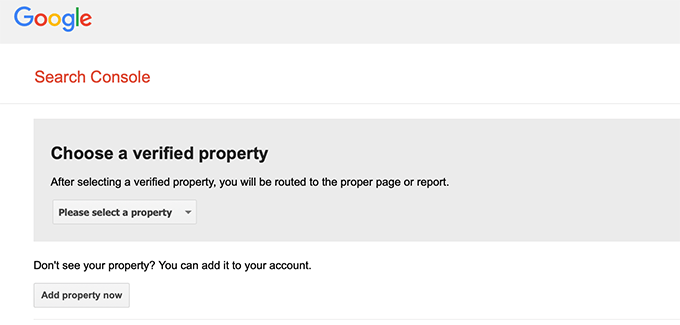

Es gibt viele robots.txt-Tests, aber wir empfehlen die Verwendung des Tools in der Google Search Console.

Zunächst müssen Sie Ihre Website mit der Google Search Console verknüpfen. Falls Sie dies noch nicht getan haben, lesen Sie unsere Anleitung, wie Sie Ihre WordPress-Website zur Google Search Console hinzufügen.

Dann können Sie das Google Search Console Robots Testing Tool verwenden.

Wählen Sie einfach Ihre Immobilie aus der Dropdown-Liste aus.

Das Tool ruft automatisch die robots.txt-Datei Ihrer Website ab und markiert die Fehler und Warnungen, wenn es welche findet.

Abschließende Überlegungen

Das Ziel der Optimierung Ihrer robots.txt-Datei ist es, Suchmaschinen daran zu hindern, Seiten zu crawlen, die nicht öffentlich zugänglich sind. Zum Beispiel Seiten in Ihrem wp-plugins-Ordner oder Seiten in Ihrem WordPress-Verwaltungsordner.

Ein weit verbreiteter Mythos unter SEO-Experten ist, dass das Blockieren von WordPress-Kategorien, -Tags und -Archivseiten die Crawl-Rate verbessert und zu einer schnelleren Indizierung und höheren Platzierungen führt.

Das ist nicht wahr. Es verstößt auch gegen die Webmaster-Richtlinien von Google.

Wir empfehlen Ihnen, das obige robots.txt-Format zu befolgen, um eine robots.txt-Datei für Ihre Website zu erstellen.

Expertenanleitungen zur Verwendung von Robots.txt in WordPress

Da Sie nun wissen, wie Sie Ihre robots.txt-Datei optimieren können, möchten Sie vielleicht einige andere Artikel über die Verwendung von robots.txt in WordPress lesen.

- Glossar: Robots.txt

- Wie man eine WordPress-Seite vor Google verbirgt

- Wie man Suchmaschinen davon abhält, eine WordPress-Website zu crawlen

- Wie man eine WordPress-Site dauerhaft aus dem Internet löscht

- Einfaches Ausblenden (Noindex) von PDF-Dateien in WordPress

- Wie man den Fehler “Googlebot kann nicht auf CSS- und JS-Dateien zugreifen” in WordPress behebt

- Wie man All in One SEO für WordPress richtig einrichtet (Ultimative Anleitung)

Wir hoffen, dass dieser Artikel Ihnen geholfen hat zu erfahren, wie Sie Ihre WordPress robots.txt-Datei für SEO optimieren können. Vielleicht interessieren Sie sich auch für unseren ultimativen WordPress-SEO-Leitfaden und unsere Expertenauswahl der besten WordPress-SEO-Tools für das Wachstum Ihrer Website.

Wenn Ihnen dieser Artikel gefallen hat, dann abonnieren Sie bitte unseren YouTube-Kanal für WordPress-Videotutorials. Sie können uns auch auf Twitter und Facebook finden.

Moinuddin Waheed

Thanks for this informative post about robots.txt file.

I didn’t know that websites should maintain this file in order to have a control over Google bots that how should they crawl over our pages and posts.

for beginner websites just starting out, is there a need to have robots.txt file or is there a way like plugin which can a make a robots.txt file for our website?

WPBeginner Support

Most SEO plugins help with setting up the robots.txt for a new site to prevent bots from scrolling sections they shouuldn’t.

Admin

Jiří Vaněk

Thanks to this article, I checked the robots.txt file and added URL addresses with sitemaps. At the same time, I had other problematic lines there, which were revealed by the validator. I wasn’t familiar with sitemaps in robots.txt until now. Thanks.

WPBeginner Support

You’re welcome, glad our guide could help!

Admin

Stéphane

Hi,

Thanks for that post, it becomes clearer how to use the robots.txt file. On most websites that you find while looking for some advice regarding the robots.txt file, you can see that the following folders are explicitly excluded from crawling (for WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

I don’t really understand the reasons to exclude those folders (is there one actually?). What would be your take regarding that matter?

WPBeginner Support

It is mainly to prevent anything in those folders from showing as a result when a user searches for your site. As that is not your content it is not something most people would want to appear for the site’s results.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC show the coverage error for “Disallow: /wp-admin/” Is this wrong?

WPBeginner Support

For most sites, you do not want anything from your wp-admin to appear as a search result so it is fine and expected to receive the coverage area when you deny Google the ability to scan your wp-admin.

Admin

Hansini

I am creating my robots.txt manually as you instructed for my WordPress site.

I have one doubt. when I write User-Agent: * won’t it allow another spamming robot to access my site?

Should I write User-Agent: * or User-Agent: Googlebot.?

WPBeginner Support

The User-Agent line is setting the rules that all robots should follow on your site, if you specify a specific bot on that line it would be setting rules for that specific bot and none of the others.

Admin

Nishant

What should we write to make google index my post?

WPBeginner Support

For having your site listed, you would want to take a look at our article below:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

should we also disallow /wp-content/themes/ ?

It is appearing in the search result when I run the command site:abcdef.com in google search

WPBeginner Support

You would not want to worry about blocking your themes folder and as you write SEO-friendly content you should no longer see the themes as a search result.

Admin

Salem

HI, What’s means ” Disallow: /readme.html & Disallow: /refer/ ” ?

WPBeginner Support

That means you’re telling search engines to not look at any referral links or the readme.html file.

Admin

sean

Hi, what are the pros and cons of blocking wp-content/uploads

Thank you

WPBeginner Support

If you block your uploads folder then search engines would not normally crawl your uploaded content like images.

Admin

Piyush

thanks for solve my problem

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Sir i m very confused about robot.txt many time i submitted site map in blogger but the after 3,4 days coming the same issue what is the exactly robot.txt.. & how submit that please guide me

WPBeginner Support

It would depend on your specific issue, you may want to take a look at our page below:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

If I no index a url or page using robots.txt file, does google shows any error in search console?

WPBeginner Support

No, Google will not list the page but if the page is listed it will not show an error.

Admin

Bharat

Hi

I have a question

i receive google search console coverage issue warning for blocked by robots.txt

/wp-admin/widgets.php

My question is, can i allow for wp-admin/widgets.php to robots.txt and this is safe?

WPBeginner Support

IF you wanted to you can but that is not a file that Google needs to crawl.

Admin

Anthony

Hi there, I’m wondering if you should allow: /wp-admin/admin-ajax.php?

WPBeginner Support

Normally, yes you should.

Admin

Jaira

May I know why you should allow /wp-admin/admin-ajax.php?

WPBeginner Support

It is used by different themes and plugins to appear correctly for search engines.

Amila

Hello! I really like this article and as I’m a beginner with all this crawling stuff I would like to ask something in this regard. Recently, Google has crawled and indexed one of my websites on a really terrible way, showing the pages in search results which are deleted from the website. The website didn’t have discouraged search engine from indexing in the settings of WordPress at the beginning, but it did later after Google showed even 3 more pages in the search results (those pages also doesn’t exist) and I really don’t understand how it could happen with “discourage search engine from indexing” option on. So, can the Yoast method be helpful and make a solution for my website to Google index my website on the appropriate way this time? Thanks in advance!

WPBeginner Support

The Yoast plugin should be able to assist in ensuring the pages you have are indexed properly, there is a chance before you discouraged search engines from crawling your site your page was cached.

Admin

Amila

Well yes and from all pages, it cached the once who doesn’t exist anymore. Anyway, as the current page is on “discourage” setting on, is it better to keep it like that for now or to uncheck the box and leave the Google to crawl and index it again with Yoast help? Thanks! With your articles, everything became easier!

WPBeginner Support

You would want to have Google recrawl your site once it is set up how you want.

Pradhuman Kumar

Hi I loved the article, very precise and perfect.

Just a small suggestion kindly update the image ROBOTS.txt tester, as Google Console is changed and it would be awesome if you add the link to check the robots.txt from Google.

WPBeginner Support

Thank you for the feedback, we’ll be sure to look into updating the article as soon as we are able.

Admin

Kamaljeet Singh

My blog’s robots.txt file was:

User-Agent: *

crawl-delay: 10

After reading this post, I have changed it into your recommended robots.txt file. Is that okay that I removed crawl-delay

WPBeginner Support

It should be fine, crawl-delay tells search engines to slow down how quickly to crawl your site.

Admin

reena

Very nicely described about robot.text, i am very happy

u r very good writer

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

What is Disallow: /refer/ page ? I get a 404, is this a hidden wp file?

Editorial Staff

We use /refer/ to redirect to various affiliate links on our website. We don’t want those to be indexed since they’re just redirects and not actual content.

Admin

Sagar Arakh

Thank you for sharing. This was really helpful for me to understand robots.txt

I have updated my robots.txt to the ideal one you suggested. i will wait for the results now

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Very helpful article. Thank you very much.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Thanks for share this useful information about us.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

thanks for update information for me. Your article was good for Robot txt. file. It gave me a piece of new information. thanks and keep me updating with new ideas.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Thanks , I added robots.txt in WordPress .Very good article

WPBeginner Support

Thank you, glad our article was helpful

Admin