Robots.txt ist eine Textdatei, die es einer Website ermöglicht, Anweisungen für Web-Crawling-Bots bereitzustellen.

Sie teilt Suchmaschinen wie Google mit, auf welche Teile Ihrer Website sie bei der Indizierung zugreifen können und auf welche nicht.

Das macht robots.txt zu einem mächtigen Werkzeug für SEO und kann auch verwendet werden, um sicherzustellen, dass bestimmte Seiten nicht in den Google-Suchergebnissen erscheinen.

Wie funktioniert Robots.txt?

Robots.txt ist eine Textdatei, die Sie erstellen können, um Suchmaschinen-Bots mitzuteilen, welche Seiten auf Ihrer Website gecrawlt und indiziert werden sollen. Sie wird normalerweise im Stammverzeichnis Ihrer Website gespeichert.

Suchmaschinen wie Google verwenden Webcrawler, manchmal auch Webroboter genannt, um Websites zu archivieren und zu kategorisieren. Die meisten Bots sind so konfiguriert, dass sie nach einer robots.txt-Datei auf dem Server suchen, bevor sie irgendeine andere Datei von der Website lesen. Ein Bot tut dies, um festzustellen, ob der Eigentümer einer Website besondere Anweisungen zum Crawlen und Indizieren seiner Website hat.

Die robots.txt-Datei enthält eine Reihe von Anweisungen, die den Bot auffordern, bestimmte Dateien oder Verzeichnisse zu ignorieren. Dies kann aus Gründen des Datenschutzes geschehen oder weil der Eigentümer der Website der Meinung ist, dass der Inhalt dieser Dateien und Verzeichnisse für die Kategorisierung der Website in Suchmaschinen irrelevant ist.

Hier ist ein Beispiel für eine robots.txt-Datei:

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml |

In diesem Beispiel gibt das Sternchen “*” nach “User-Agent” an, dass die Anweisungen für alle Suchmaschinen gelten.

Als Nächstes erlauben wir den Suchmaschinen, die Dateien in unserem WordPress-Uploads-Ordner zu crawlen und zu indizieren. Dann verbieten wir ihnen das Crawlen und Indizieren von Plugins und WordPress-Verwaltungsordnern.

Beachten Sie, dass Suchmaschinen-Bots davon ausgehen, dass sie eine URL indizieren können, wenn Sie diese nicht verbieten.

Schließlich haben wir die URL unserer XML-Sitemap angegeben.

Wie man eine Robots.txt-Datei in WordPress erstellt

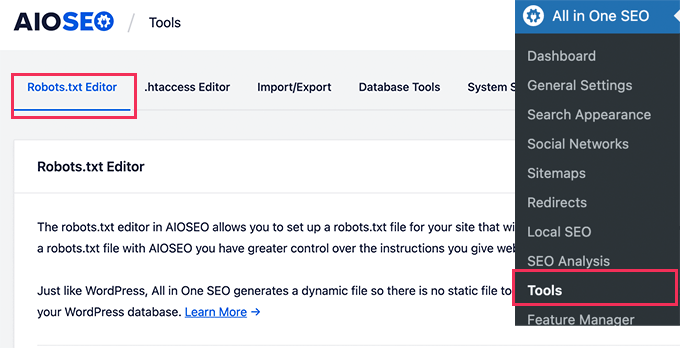

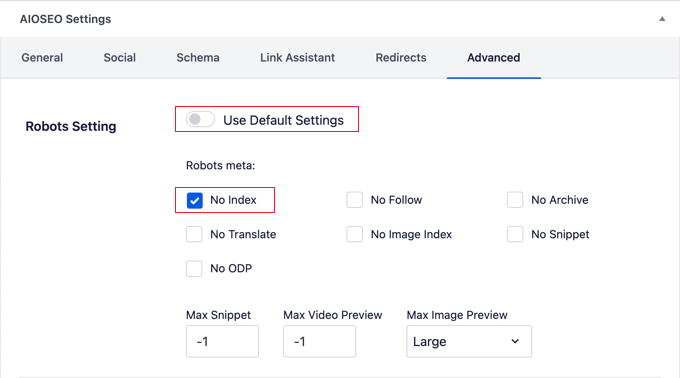

Der einfachste Weg, eine robots.txt-Datei zu erstellen, ist die Verwendung von All in One SEO. Es ist das beste WordPress-SEO-Plugin auf dem Markt und verfügt über einen einfach zu bedienenden robots.txt-Dateigenerator.

Ein weiteres Tool, das Sie verwenden können, ist WPCode, ein leistungsfähiges Code-Snippets-Plugin, mit dem Sie Ihrer Website einfach und sicher benutzerdefinierten Code hinzufügen können. Die Pro-Version enthält eine praktische Funktion, mit der Sie die robots.txt-Datei schnell bearbeiten können.

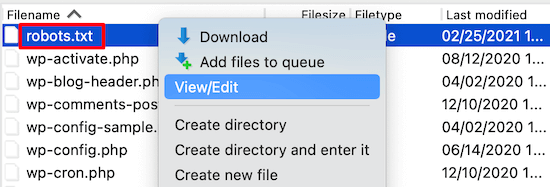

Wenn Sie jedoch mit Code vertraut sind, können Sie die Datei robots.txt auch manuell erstellen. Sie müssen einen FTP-Client verwenden, um die robots.txt-Datei zu bearbeiten. Alternativ können Sie den von Ihrem WordPress-Hosting bereitgestellten Dateimanager verwenden.

Weitere Einzelheiten zur Erstellung einer robots.txt-Datei finden Sie in unserem Leitfaden zur Optimierung der robots.txt-Datei von WordPress für SEO.

Wie man Robots.txt verwendet, um das Crawlen einer Website durch Suchmaschinen zu verhindern

Suchmaschinen sind für die meisten Websites die wichtigste Quelle für Besucher. Es gibt jedoch ein paar Gründe, warum Sie Suchmaschinen davon abhalten sollten, Ihre Website zu indizieren.

Wenn Sie zum Beispiel Ihre Website noch im Aufbau haben, werden Sie nicht wollen, dass sie in den Suchergebnissen erscheint. Das Gleiche gilt für private Blogs und Unternehmensintranets.

Sie können Disallow-Regeln in Ihrer robots.txt-Datei verwenden, um Suchmaschinen zu bitten, Ihre gesamte Website oder nur bestimmte Seiten nicht zu indizieren. Detaillierte Anweisungen finden Sie in unserem Leitfaden, wie Sie Suchmaschinen davon abhalten, eine WordPress-Website zu crawlen.

Sie können Tools wie All in One SEO verwenden, um diese Regeln automatisch zu Ihrer robots.txt-Datei hinzuzufügen.

Es ist wichtig zu wissen, dass nicht alle Bots eine robots.txt-Datei beachten. Einige böswillige Bots lesen sogar die robots.txt-Datei, um herauszufinden, welche Dateien und Verzeichnisse sie zuerst angreifen sollten.

Auch wenn eine robots.txt-Datei die Bots anweist, bestimmte Seiten auf der Website zu ignorieren, können diese Seiten dennoch in den Suchergebnissen erscheinen, wenn sie mit anderen gecrawlten Seiten verlinkt sind.

Wir hoffen, dass dieser Artikel Ihnen geholfen hat, mehr über robots.txt in WordPress zu erfahren. Vielleicht möchten Sie auch unsere Liste mit weiterführenden Artikeln über nützliche WordPress-Tipps, -Tricks und -Ideen lesen, die Sie weiter unten finden.

Wenn Ihnen dieser Artikel gefallen hat, dann abonnieren Sie bitte unseren YouTube-Kanal für WordPress-Videotutorials. Sie können uns auch auf Twitter und Facebook finden.

Additional Reading

- SEO

- So fügen Sie Ihre WordPress-Site zur Google Search Console hinzu

- Wie man Suchmaschinen davon abhält, eine WordPress-Seite zu crawlen

- Was ist eine XML-Sitemap? Wie man eine Sitemap in WordPress erstellt

- Wie man eine WordPress-Seite vor Google verbirgt (4 Methoden)

- Wie Sie Ihre WordPress Robots.txt für SEO optimieren